Ist das Kunst? Persönliche Reflexionen über meine KI-Kunstwerke

Marisa Tschopp

Diese Diskussion ist wichtig für die Menschheit

Die publik gewordenen Fälle der Hololens oder des Project Maven zeigen eindrücklich, auf welch dünnem Eis sich Tech-Firmen bewegen. Vor allem jene Giganten, die im Rampenlicht stehen wie Microsoft oder Google. Zum grossen Skandal reicht es zwar nicht, dennoch tragen diese beiden Fälle wieder ein Stück dazu bei, sich über die Auswirkungen von Technologien mit doppeltem Verwendungszweck Gedanken zu machen. Diese finden nicht nur im kommerziellen Gebrauch, sondern auch im militärischen Bereich Anwendung oder werden mit guten oder bösen Absichten verwendet (Brundage et al, 2018). Diese Probleme gibt es nicht erst seit KI, sondern haben eine lange Tradition und sind fest verankert in den Chemie- oder den Ingenieurswissenschaften, so zum Beispiel die Raketentechnologie (Gut gemeint: Mondlandung, böse gemeint: Angriffswaffe) oder Nukleartechnologie (eher gut gemeint: Energie, böse gemeint: Atombomben).

Right now: Technology, computing power, programming languages, computer code, encryption, information, big data, algorithms, investment, they all have dual use. Forbes, 2019

KI und angrenzende Technologien und Subtechnologien bilden zusammen einen prekären Mix, der einerseits positiv nahezu jeden Sektor von der Medizin zum Städtebau transformiert, andererseits auch fragwürdige bis hin zu gefährliche Implikationen mit sich bringt vom superpräzisen Hacking von Datenplattformen zum Überwachungsstaat und Verlust von Privatsphäre ohne Möglichkeiten zum öffentlichen Einverständnis. Die grössten ethischen Bedenken im Kontext Technologie laut Vallor et al. von der Santa Clara Universität sind (2018):

Eine Patentlösung zum richtigen Umgang mit KI gibt es leider nicht. In der Regel ist meist eine Fall zu Fall Analyse des ethischen Dilemmas nötig. Dual-Use stellt immer die Frage, ob die Forschung, Technologie oder das Produkt eine konkrete Bedrohung oder ein ausreichend hohes Risiko darstellen, um für bösartige Zwecke verwendet zu werden. So stellt sich die Frage, ob diese die Gesundheit oder Sicherheit der Menschen gefährden können, auch wenn bösartiger Nutzen niemals gewollt oder das primäre Ziel ist. Das Dilemma stellt nicht nur Entwickler vor die Wahl, ob sie ein Produkt entwickeln wollen/ dürfen, mit dem sie anderen helfen können, welches aber definitiv bösartige Menschen dazu befähigt, Böses zu tun. Macht ihn das zum Mittäter? Oder die Institution, die Investoren oder Firma? Rechtfertigt dies das Vorhaben? Überwiegt das Potential Gutes zu bewirken gegenüber der vorhersehbaren Gefahr? (Brazzetti et al, 2018)

Oft entstehen mögliche negative Konsequenzen erst im Laufe der Forschung und Entwicklung, welche vorher nicht antizipiert wurden. Das heisst, es gab zu keiner Zeit die Intention etwas zu entwickeln, das Menschen Schaden zufügt. Ausgedrückt im Google Code of Ethics Jargon gibt es also zwei wichtige Unterscheidungen: Don’t be evil (Tue nichts Böses / absichtliche negative Folgen) und Don’t help perpetrate evil (Helfe nicht dabei Böses zu tun / unbeabsichtigte negative Folgen). So zum Beispiel der Entscheid von OpenAI ihr Programm nicht zu veröffentlichen , da es zu grosse Gefahr von Missbrauch, zum Beispiel bei der Generierung von Fake News, mit sich bringt.

Im militärischen Kontext verschärft sich das Dilemma, wenn es sich um Forschung und Entwicklung für Technologien und Waffen handelt. Für offensive Militärforschung ist der Fall relativ klar. Diese ist ethisch nicht vertretbar, da die primäre Absicht ist, Menschen Schaden zuzufügen. Das grössere Dilemma besteht in der defensiven militärischen Forschung, der Entwicklung von defensiven Waffensystemen, welche grundsätzlich dem Wohle der Bevölkerung dienen. Zuletzt noch, wenn bewusst Technologien entwickelt werden die zivile, kommerzielle als auch militärische Anwendungen finden, da hier zusätzlich auch noch ökonomische Interessenskonflikte einfliessen (Brazzetti et al 2018).

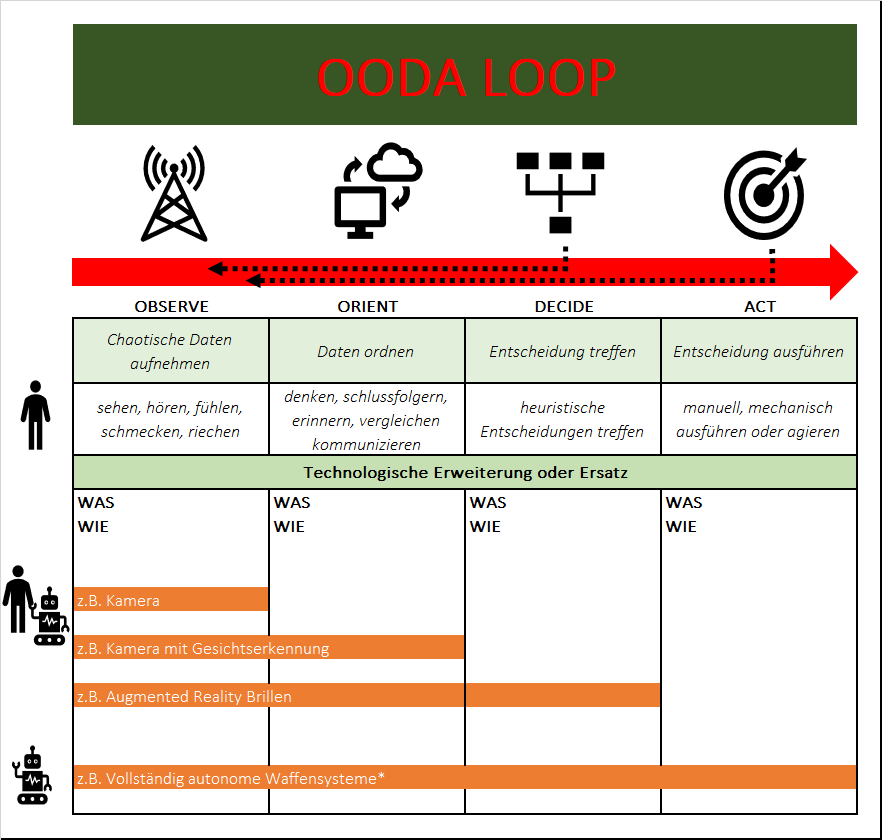

Die Zusammenarbeit mit dem US Department of Defense ist lukrativ. Der Bedarf an ausgefeilten Technologien, den das DoD ausdrückt, ist gross, um das Land, seine Grenzen, seine Soldaten und die zivile Bevölkerung besser zu verteidigen. Grundsätzlich ein Gedanke der unterstützenswert ist, schliesslich sind derzeit Soldaten in Kriegsgebieten unterwegs, die es bestmöglich zu schützen gilt. Unterschiedliche Technologien können z.B. in Entscheidungsprozessen helfen genauer, schneller und effektiver zu handeln. Im Sinne des defensiven Gedankengutes, geht es darum schneller als ein angreifender Gegner zu sein. Der Militärstratege John Boyd war Entwickler des OODA Loops, eines Informations- und Entscheidungskonzepts. Die folgende Grafik veranschaulicht diesen Prozess und dient als Überlegungsgrundlage, in welchen Phasen diverse Technologien eingesetzt werden sollen, um die Schnelligkeit zu erhöhen.

Die menschliche Informationsaufnahme, die Ordnung und Verarbeitung von Informationen, aber auch in der letztlichen Ausführung der Entscheidung, kann von einer Technologie unterstützt oder sogar gänzlich ersetzt werden (Soft- und Hardware). Die Trennung in die jeweiligen Bereiche ist nicht ganz so strikt wie in der Grafik veranschaulicht, zumal die Komponenten selbstverständlich voneinander abhängen und nicht so isoliert betrachtet werden können. Dennoch macht diese Aufteilung durchaus Sinn, um die kritischen Hauptfunktionen genauer zu beleuchten. Der kritische Teil auf Ebene des Völkerrechts ist der letzte, welcher die tatsächliche Handlung darstellt. Sobald diese nicht mehr von einem Menschen ausgeführt wird, wird von einer (tödlichen) autonomen Waffe gesprochen. Auch wenn alle Hilfsmittel theoretisch legitim sind, so wird die Lage dennoch etwas verwässert. Entweder weil der Entscheidungsprozess so schnell ist, dass keine ernsthaften menschlichen Überlegungen mehr getroffen werden können oder weil unklar ist, wie gut die Daten sind, die zu der menschlichen Entscheidung geführt haben (Defekte und Manipulation miteingeschlossen). So könnte sich die scheinbar legitime Hololens, mit den individuell eingebauten Algorithmen, vielleicht in einer Grauzone bewegen.

Microsofts zweite Generation der Hololens ist eine Brille, die mittels Augmented Reality (AR), menschliche Anatomie genauso wie Teile an einem Motorrad vor Augen führen kann. Zur Verarbeitung von Sensormaterial soll unter anderem auch künstliche Intelligenz in Form von neuronalen Netzwerken zum Einsatz kommen. Dass Microsoft mit dieser Technologie Soldaten helfen soll effizienter zu töten, stösst einigen Mitarbeitern und Ethikern sauer auf. Unter anderem auch, weil das so nicht abgesprochen war.

Microsoft Mitarbeiter fordern mit einem offenen Brief ein Ende des 480 Millionen Dollar Projekts:

We are a global coalition of Microsoft workers, and we refuse to create technology for warfare and oppression. […] We did not sign up to develop weapons, and we demand a say in how our work is used. […] The contract’s stated objective is to rapidly develop, test, and manufacture a single platform that Soldiers can use to Fight, Rehearse, and Train that provides increased lethality, mobility, and situational awareness necessary to achieve overmatch against […] our adversaries.[…] (it) works by turning warfare into a simulated video game […]. Brad Smith’s (CEO of Microsoft) (suggests that employees) would be allowed to move to other work within the company […]. (This) ignores the problem that workers are not properly informed of the use of their work.[…] As employees and shareholders we do not want to become war profiteers.[…]

Die Schlüsselpunkte ihrer Probleme sind:

Die Führungsriege stellt sich ganz klar hinter die amerikanische Regierung und bleibt bei ihrem Engagement, da Microsoft ihrem Heimatland, mit seinen demokratischen Werten, den Zugang zur bestmöglichen Technologie nicht verweigern möchte. Die Möglichkeit, an einem anderen Projekt zu arbeiten, ist völlig sinnlos, denn das geht nicht im Geringsten auf die Bedürfnisse der Mitarbeiter ein. Einziges Zugeständnis ist die Befürwortung eines offenen Dialogs. Doch ein Dialog mit verhärteten Fronten wird eine harte Nuss. Ein Einbezug der Öffentlichkeit, NGO’s und/oder Mediatoren ist zwingend nötig, um an gemeinsamen Lösungen zu arbeiten.

Es wird im Video sehr deutlich worum es geht: Schnelligkeit. Zudem findet eine Kontexterweiterung statt, zum Beispiel von Drohnen aus der Luft, um auf einer grösseren Datenbasis bessere Entscheidungen zu treffen. Dies spiegelt sich im obengenannten OODA Loop wider: Wer schneller zur Entscheidung kommt, gewinnt. Was bessere Entscheidungen sind, kann an dieser Stelle nicht einfach diskutiert werden. Ein visuelles System, wie bspw. eine Augmented Reality Brille wird erst durch die bereitgestellten Algorithmen zum Leben erweckt. Der Machine Learning (hier als Oberbegriff verwendet) Anbieter ist dabei frei wählbar. So kann der OODA Loop in den Phasen Observe, Orient und Decide entsprechend beeinflusst werden. Handlungsträger ist dabei immer noch der Mensch, der in seiner Entscheidung zwar beeinflusst wird, aber letztlich immer noch das Kommando abgibt. Die Verantwortungslage bei diesem Human in the Loop Prozess ist aus humanitärer Sicht ziemlich klar.

Je mehr und kompliziertere Technologie im Krieg verwendet wird, desto schwammiger wird die Verantwortungslage und sorgt weltweit für Kopfzerbrechen. Der Aufruf nach klaren Regeln wird laut, jedoch steckt die Politik seit Jahren in Definitionen fest. Die allgemeine Bevölkerung, sogar die eigenen Mitarbeiter kriegen vieles gar nicht mit, da das ganze Thema verständlicherweise nicht an die grosse Glocke gehängt wird. Krieg im Allgemeinen, insbesondere aber in Verbindung mit KI und Killerrobotern ist ein gefundenes Medienfressen und soll wenn möglich unter Dach und Fach bleiben, wie es bei Google im Project Maven gewünscht wurde.

Tausende Google Mitarbeiter fordern mit einem offenen Brief ein Ende des 7 bis 30 (Zahlen variieren) Millionen Dollar Projektes. 10 bis 20 Google Mitarbeiter kündigten ihre Anstellung aufgrund dieser Affäre:

We believe that Google should not be in the business of war. Therefore we ask that Project Maven be cancelled […]. Google is implementing Project Maven, a customized AI surveillance engine that uses Wide Area Motion Imagery data captured by US Government drones to detect vehicles and other objects, track their motions, and provide results to the Department of Defense.[…] By entering into this contract, Google will join the ranks of companies like Palantir, Raytheon, and General Dynamics. The argument that other firms, like Microsoft and Amazon, are also participating does not make this any less risky for Google. Google’s unique history, its motto Don’t Be Evil, and its direct reach into the lives of billions of users set it apart.[…] Building this technology to assist the US Government in military surveillance and potentially lethal outcomes is not acceptable.

Die Schlüsselpunkte betonen hier ganz klar die ausgeprägte und berühmte Firmenkultur von Google, die trotz der Diskriminierungsfälle, ein grosser Pluspunkt für aktuelle wie auch potenzielle Mitarbeiter darstellt. Wie auch bei Microsoft vertreten die involvierten Mitarbeiter grundlegend ein liberales Gedankengut und wollen keine Profiteure des Krieges sein. Einen ziemlich negativen Nachgeschmack erhält die ganze Geschichte, weil durch viele Emails der Chefetage klar wird, dass aus ihrer Sicht die Angelegenheit so wenig wie möglich an die Öffentlichkeit geraten soll.

Beide Fälle sind sehr unterschiedlich und schwer zu vergleichen, wenn die internen Details nicht bekannt sind. Doch geht es hier nicht um Richtig oder Falsch, sondern soll dies als Grundlage dienen darüber nachzudenken, wie Technologie eingesetzt werden soll. Laut Dr. Frank Sauer, Senior Researcher an der Universität der Bundeswehr in München, kann die Diskussion über Killerroboter befremdlich und exotisch wirken. Er sieht die Debatte jedoch als Teil eines grossen Ganzen. Sie ist ein Teilaspekt der großen Frage nach dem zukünftigen Verhältnis von Mensch und Maschine und stellt die Menschen nicht vor die Frage, ob, sondern wie sie mit Wissenschaft und Technologie umgehen wollen.

Microsoft Mitarbeiter fordern wie Google den klaren Exit: Doch löst diese Exitstrategie wirklich das Problem? Laut Paul Scharre, Senior Fellow und Direktor des Technology and National Security Program im Center for a New American Security, wird der Anbieter einfach ersetzt und jemand anderes macht die Arbeit. Im schlimmsten Fall vielleicht jemand, der über weniger Knowhow und Skills verfügt, als die ganz grossen Player. Damit ist die ethische Zwickmühle perfekt.

Die Philosophin Megan Welle, Philosophin und in einem Machine Learning Unternehmen, fügt die folgende Idee hinzu, die dieses ganze Dilemma noch schwieriger macht:

Microsoft entschied sich für eine Zusammenarbeit mit dem US Militär, weil es die Verteidigung der USA unterstützt und wünscht, dass die Menschen, die es verteidigen, Zugang zu den besten Technologien des Landes haben, auch von Microsoft. Die ethische Grundeinstellung ist, dass Unternehmen eine moralische Verpflichtung haben Loyalität gegenüber der Verteidigung des Ursprungslandes zu wahren. Es ist wichtig zu wissen, dass Microsoft in den USA HQ ist, obwohl der CEO ursprünglich aus Indien stammt. Microsoft unterstützte ihre Position, indem sie indirekt andeutete, dass US-amerikanische Unternehmen diese Technologie nicht für die USA entwickeln, sondern sie an anderer Stelle entwickelt und eingesetzt werden. Diese unausgesprochene Angst setzt sich in der gesamten Militär- und Geschäftswelt fort. Angesichts des Rücktritts von Google aus Project Maven wurde Google vorgeworfen, Chinas Militär indirekt zu helfen.

Eine grosse Stakeholder Analyse ist gefragt, in der theoretisch nicht nur die Bedürfnisse aller Beteiligten einbezogen werden müssen, sondern auch derer, die betroffen sind und das ist im Prinzip die gesamte Zivilisation:

Worum geht es hier also? Geld? Macht? Transparenz? Demokratie? Aufklärung? Weltfrieden? Das weiss fast keiner vom anderen, oft nicht einmal von sich selbst. Es gäbe da einen Weg, welcher gekennzeichnet ist durch Empathie, kognitivem Verständnis und authentischer Kommunikation.

Das grosse Problem der heutigen Zeit besteht darin, dass es schwierige Themen sind, die schwierig zu kommunizieren und schwierig zu hören sind, ohne sich vom moralischen Zeigefinger bevormundet zu fühlen. Es gibt tausende Themen wie Klimawandel, Hungersnöte, Gleichstellung, Bürgerkriege, Masseneinwanderung, Regenwaldabholzung und aussterbenden Tiere, die es zu bewältigen gibt. Die allgemeine Bevölkerung ist überfordert und genervt, gegebenenfalls auch verängstigt und machtlos. Nationalismus und Ausgrenzung, Lethargie und Rückzug sind die logische Konsequenzen. Diese Abwehrreaktionen wurden schon 1966 von J.W. Brehm formuliert: Sobald Menschen eine Einschränkung ihrer Willens- und Entscheidungsfreiheit wahrnehmen (der moralische Zeigefinger), machen sie dicht und wählen sogar Verhaltensweisen, die selbst für sie völlig irrational sind, nur um die kognitive Wahlfreiheit und die resultierende Bestärkung des Selbst wieder herzustellen.

Die Moral von der Geschichte ist klar: Es muss eine Änderung stattfinden, wie über kritische Themen kommuniziert wird, z.B. KI oder Krieg, oder KI im Krieg. Weg von Bedrohung und Hype zu Fakten und Visionen. Nur wie? Aus der Konsumenten- und Werbepsychologie stammen wichtige Erkenntnisse. Eine Studie zum Spendenverhalten hat gezeigt, dass Menschen eher bereit waren zu spenden, wenn auf dem Spendenbild ein fröhliches Kind auf dem Weg in die Schule gezeigt wurde, als wenn das Kind unternährt im Krankenhaus lag (Zimbardo & Gerrig, 2004; Kroeber-Riel et al., 2009). Schockbilder und Videos erregen Aufmerksamkeit, aber lassen keinen Dialog zu. Doch genau dieser ist so dringend nötig.

Diese beiden Fälle zeigen auf grandiose Art und Weise auf, wie individuell und komplex der technologische Fortschritt das Leben macht und, dass es nicht die eine richtige Lösung gibt. Aus psychologischer Sicht bewegt sich Krieg an den Schnittpunkten zwischen Aggression und Vorurteilen, ausgelöst durch religiöse, ethische oder kulturelle Unterschiede. Wichtig zu verstehen ist, dass böse Taten nicht zwingend von bösen Menschen begangen werden. Diese Banalität des Bösen hat die psychologische Forschung mehrfach bestätigt: Jeder Mensch ist fähig Böses zu tun. Die situativen Faktoren sind es viel mehr, die zu Formen hoch-organisierter Aggression führen: Schwierige Lebensbedingungen, politische Umbrüche, knappe Ressourcen, charismatische Führer. Die Forschung hat gezeigt, dass verbaler Widerstand durchaus geäussert wird, woran es allerdings fehlt sind leichtere Exit-Strategien. Denn ein verbaler Widerstand ohne Veränderung auf Verhaltensebene, bringt oft nicht den gewünschten Effekt (vgl. Zimbardo & Gerrig, 2004). Es gilt diese beiden Fälle sorgsam weiter zu verfolgen, da hier wichtige Erkenntnisse gezogen werden können. Bei Google haben vermutlich die tatsächlichen Kündigungen den Exit-Entscheid hervorgerufen. Ob das jetzt die bessere Entscheidung war als jene von Microsoft das Militär zu unterstützen, muss sich noch herausstellen.

Selbstverständlich kann niemals sichergestellt werden, dass Forschung und Technologie nicht in die falschen Hände gerät. Gewalt und Aggression werden immer ein Teil der Menschheit sein. Doch die Fähigkeit zu hochorganisierter Gewalt in Form von Krieg liegt genauso in menschlicher Hand, wie die Fähigkeit zu hochorganisierter Konfliktlösung in Form von Frieden.

Unsere Spezialisten kontaktieren Sie gern!

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Unsere Spezialisten kontaktieren Sie gern!