Angriffsmöglichkeiten gegen Generative AI

Andrea Hauser

So funktionieren Audio-Deepfakes

Das Vorgehen zur Erstellung von Audio Deepfakes ist ähnlich wie bei visuellen Deepfakes aber dennoch anders. Ähnlich ist, dass die Audio Deepfakes auf den gleichen Prinzipien der Berechnung mit Neuronalen Netzwerken beruhen. Die Herangehensweise an die Verarbeitung von Stimmmaterial ist jedoch aufgrund der Ausgangslage anders. Für die Erstellung eines Audio Deepfakes werden klare Aufnahmen eines Sprechers, möglichst ohne Unterbrechungen, Hintergrund- oder Störgeräuschen, benötigt. Je mehr solches Material zur Verfügung steht, umso besser wird der Audio Deepfake. Der Ansatz aktueller Tools ist es, Text in der Stimme einer gewählten Person vorzulesen.

In einem ersten Schritt muss dem Modell beigebracht werden in einer bestimmten Sprache zu lesen und dieses Gelesene wiedergeben zu können. Dies basiert auf einer generischen Stimme, für die viel Stimmmaterial, mindestens 24 Stunden Audio, vorliegt. Zudem müssen für die Aufnahmen Transkripte vorhanden sein, damit schlussendlich Text zu Stimmlauten umgewandelt werden kann. Das Modell wird mit den Aufnahmen und den Transkripten gefüttert. Die dem Modell mitgegebenen Text- und Audioabschnitte sollten für das Training jeweils nicht länger als 10 Sekunden sein und mit dem Ende eines Wortes aufhören. Das bedeutet, dass für die Aufbereitung der Daten für ein solches generisches Modell ein grosser Aufwand notwendig ist. Einerseits müssen genügend gute Aufnahmen vorhanden sein andererseits müssen die Aufnahmen und Texte in den vom Modell erwarteten Zustand gebracht werden. Nachdem das Material aufbereitet wurde, wird eine lange Zeit gerechnet, damit das Modell eine Korrelation zwischen dem Text und dem Audio herstellen kann. Daraus entsteht das generische Grundmodell in der gewünschten Sprache, mit dem im nächsten Schritt mit der effektiv gewünschten Stimme ein Finetuning vorgenommen werden kann.

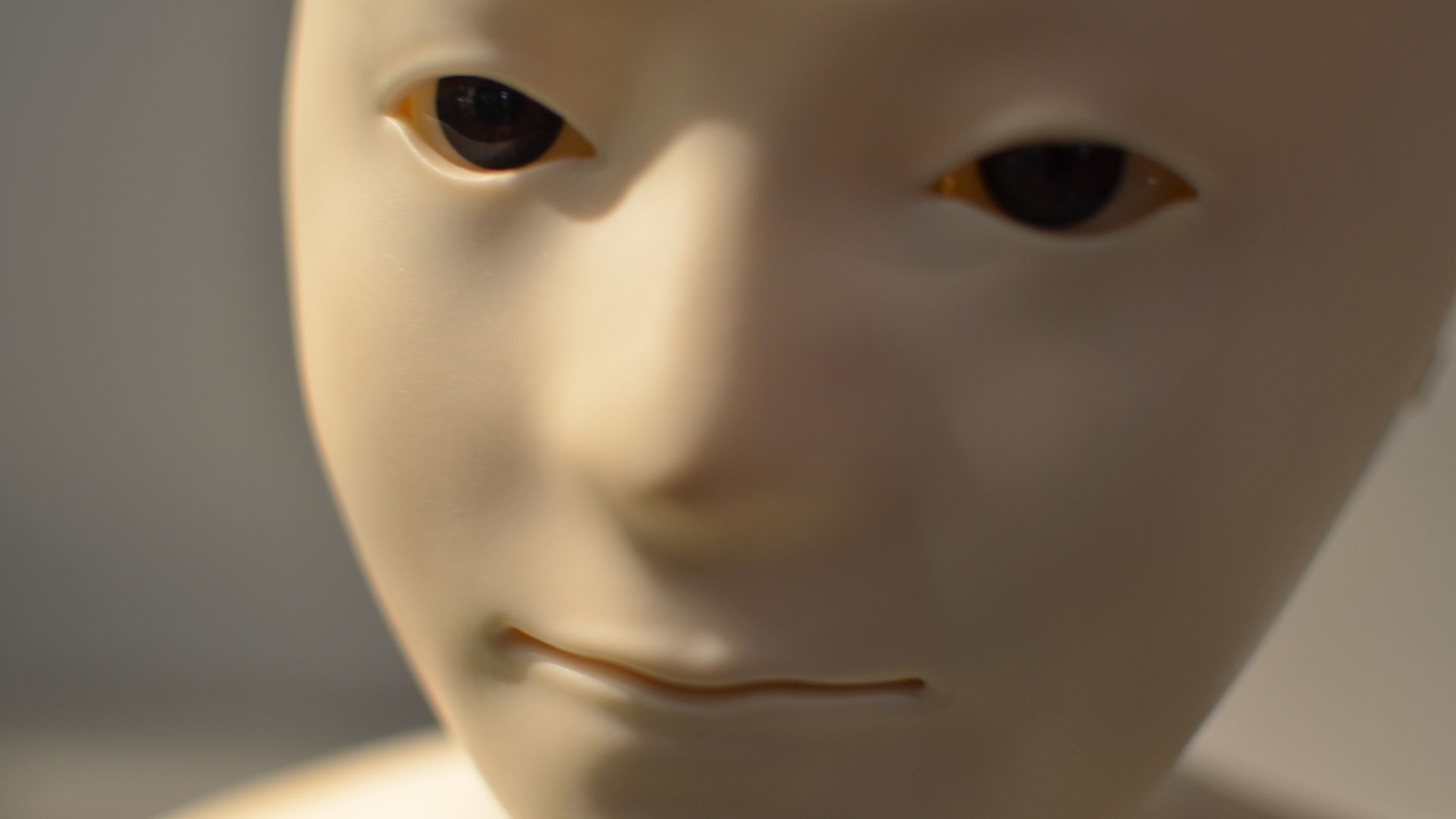

Das Finetuning benötigt nochmals etwa 30% des Zeitaufwandes, der für das Training des Grundmodells gebraucht wurde. Vom gewünschten Sprecher sind etwa 2.5 bis 3 Stunden Aufnahmen der Stimme notwendig, um ein gutes Resultat zu erzielen. Die aus diesem Finetuning erhaltenen Resultate klingen allerdings noch relativ metallisch und Roboter-ähnlich. Der Grund dafür ist, dass in diesem Training nur auf die wichtigsten Frequenzen trainiert wurde, da der rechnerische und zeitliche Aufwand viel zu gross wäre, um für alle vorhandenen Frequenzen korrekt zu trainieren. Damit aus der metallischen Stimme eine besser klingende Imitation beziehungsweise eine nicht mehr erkennbare Emulation der Stimme wird, wird noch ein letzter Schritt benötigt. Die erhaltenen Resultate werden in einen sogenannten Neural Vocoder gegeben, der die Lücken in den Frequenzen füllt und dem Ganzen somit einen natürlichen Klang gibt.

Es gibt unterschiedliche öffentlich zur Verfügung stehende Tools. Zwei dieser Tools die sehr vielversprechend aussehen sind TTS von Mozilla und tacotron2 von NVIDIA. Für beide finden sich Anleitungen für die Benutzung, es wird jedoch schnell klar, dass die aktuell vorhandenen Tools technisches Verständnis sowie Verständnis dafür, wie Audio Deepfakes funktionieren, benötigen.

Auf YouTube lassen sich viele Beispiele für Resultate von Audio Deepfakes mit Tacotron2 finden. Zum Beispiel der Kanal Vocal Synthesis nutzt diese Vorgehensweise. Bei den öffentlich verfügbaren Tools sind die Resultate jedoch meist hörbar manipuliert.

In diesem Video einer Imitation von Donald Trump sind noch deutlich irritierende Überbleibsel der Verarbeitung zu hören. Wenn dieser Klipp jedoch noch mit einem lauten Hintergrundgeräusch wie zum Beispiel einer Party oder einer schlecht klingenden Verbindung hinterlegt werden würde, und nichts Bösartiges erwartet wird, könnten damit durchaus Personen getäuscht werden.

Es gibt allerdings auch bessere Beispiele wie der Clip von Speaking of AI, in dem eine Imitation von Homer Simpson zu hören ist.

Die Beispiele von diesem YouTube-Kanal werden allerdings mit einer Methode erstellt, die nicht öffentlich zugänglich ist. Es zeigt allerdings auf, dass sich bereits heute schon erstaunliche Resultate erzielen lassen.

In Kombination mit visuellen Deepfakes lässt sich damit potenziell eine vollständige Imitation einer Person erstellen. Daraus ergeben sich ähnliche Vor- und Nachteile wie bereits in der Einführung zu Deepfakes besprochen.

Zusätzlich kommen allerdings noch weitere Punkte auf. Mit der Möglichkeit Stimmen zu imitieren, können überzeugende telefonische Phishing-Angriffe auf Unternehmen ausgeführt werden. Des Weiteren gibt das grundsätzliche Bestehen der Technologie Personen die Möglichkeit, Video- oder Audiobeweise als gefälscht abzuweisen, egal ob diese nun wahr oder falsch sind.

Als positiver Punkt für die Technologie soll festgehalten werden, dass damit Stimmen von Personen, die ihre Stimme durch eine Krankheit oder ähnliches verloren haben, nachgestellt werden können. Somit wird es möglich personalisierte Computerstimmen als Stimmersatz anzubieten.

Es wäre mindestens sinnvoll, beim Verdacht eines gefälschten Anrufs aufzulegen und die Person zurückzurufen und sich das Besprochene nochmals bestätigen zu lassen. Dabei sollte der Rückruf nicht auf eine am Telefon angegebenen Nummer gehen, sondern auf die bekannte Nummer der Person die angeblich angerufen hat.

Die Möglichkeit realistische Audio Deepfakes zu erstellen, besteht bereits heute schon. Mit den aktuell bestehenden, öffentlich verfügbaren Tools ist es allerdings notwendig ein gewisses technisches Verständnis zu besitzen. Nichtsdestotrotz sollten sich Unternehmen Gedanken machen, wie sie in Zukunft zum Beispiel mit möglicherweise gefälschten Telefonanrufen umgehen und wie das Personal darauf geschult werden soll.

Unsere Spezialisten kontaktieren Sie gern!

Andrea Hauser

Andrea Hauser

Andrea Hauser

Andrea Hauser

Unsere Spezialisten kontaktieren Sie gern!