Ist das Kunst? Persönliche Reflexionen über meine KI-Kunstwerke

Marisa Tschopp

So evaluiert man ein Sprachmodell

In letzter Zeit haben grosse Sprachmodelle (LLMs) wie sie durch ChatGPT genutzt werden, nicht nur in der KI-Forschung, sondern auch in der breiten Öffentlichkeit eine beispiellose Aufmerksamkeit erhalten. Die umfangreiche Berichterstattung in den Mainstream-Medien macht es für Endbenutzer äusserst schwierig, einen vernünftigen Überblick über die Systeme und ein Verständnis dafür zu erhalten, was diese Systeme tatsächlich leisten können und wie sie am besten und sichersten genutzt werden können. Im Bereich der LLMs, wo fast täglich Neuigkeiten und Updates zu den neuesten Funktionen veröffentlicht werden, sind Benutzer oder potenzielle Benutzer von neuen Möglichkeiten überwältigt, wie sie Informationen abrufen können. Wie kann man am besten mit der herausfordernden Situation umgehen, in der Benutzer mit verschiedenen Optionen von verschiedenen LLMs überschwemmt werden und welche Lösung ist für verschiedene Anwendungsfälle am besten geeignet?

Wir haben mit drei Bachelor-Studenten (HSLU), die sich auf AI & ML spezialisiert haben, zusammengearbeitet, um LLMs zu untersuchen, die im nächsten Jahr als Buchkapitel veröffentlicht werden sollen. Unser Ziel war es, eine Nutzerperspektive dieser Systeme zu gewinnen und ihre Fähigkeiten besser zu verstehen. Durch eine Reihe von Gruppensitzungen haben wir die LLMs gründlich getestet und unsere Ergebnisse umfassend in dem bevorstehenden Buchkapitel zusammengefasst. Allerdings möchten wir die Kernergebnisse bereits in diesem Blogbeitrag teilen. Unser bevorstehendes Kapitel bietet eine umfassende Analyse darüber, wie verschiedene LLMs unsere Erwartungen erfüllt haben und vergleicht ihre Leistung, um festzustellen, welches am besten für bestimmte Szenarien geeignet ist. Wir glauben, dass dieses kommende Kapitel eine angemessene Einführung in LLMs für Forscher und Praktiker darstellt, die das Potenzial dieser Systeme in verschiedenen Disziplinen erkunden möchten. Und wir hoffen, dass diese kürzere Form auch zur Vertiefung motiviert.

Grosse Sprachmodelle (LLMs) wie GPT-3 haben den Bereich der Sprachverarbeitung revolutioniert, die Aufmerksamkeit der Medien auf sich gezogen und das Interesse und die Investitionen in diese Technologie erhöht. Die riesige Menge an Inhalten, die über LLMs generiert werden, kann jedoch zu einer Informationsüberlastung führen, und es gibt Bedenken hinsichtlich ihres Potenzials, Fake News und Deep Fakes zu erzeugen.

Einige führende Köpfe im Bereich der Künstlichen Intelligenz haben einen offenen Brief verfasst, in dem sie eine Pause bei der Entwicklung leistungsfähigerer LLMs fordern, um sich auf Sicherheit und Transparenz zu konzentrieren. Dieser Brief wurde bisher von fast 30 Tausend Menschen unterzeichnet (obwohl er auch kritisiert wurde). Angesichts der Herausforderungen, die ihre Verwendung mit sich bringt, ist es von entscheidender Bedeutung, über die neuesten Entwicklungen und bewährten Verfahren für den sicheren und wirksamen Einsatz von LLM informiert zu bleiben. Strategien zur Bewältigung dieses Problems sind erforderlich, um ein umfassendes Verständnis von LLMs wie ChatGPT und anderen ähnlichen Systemen zu erlangen.

Sprechende Maschinen faszinieren Menschen auf der ganzen Welt. Das erste grundlegende Sprachmodell, Eliza, wurde in den 1960er Jahren am MIT entwickelt, hatte begrenzte Fähigkeiten und wurde von den Nutzern stark vermenschlicht. Die Veröffentlichung von Siri durch Apple im Jahr 2011 markierte den Beginn der konversationellen KI, und auch andere grosse Technologieunternehmen brachten bald ihre Versionen digitaler Assistenten auf den Markt, die in grossem Umfang in unsere Häuser eindringen. Konversationelle KI, wie Siri, ist darauf ausgelegt, Eingaben in natürlicher Sprache in Form von Sprache oder Text zu verstehen und darauf zu reagieren, und kann Aufgaben ausführen und Befehle erteilen. Der Bereich der Verarbeitung natürlicher Sprache entwickelte sich weiter und führte zur Schaffung des Transformatormodells und zur Veröffentlichung von GPT-3 im Jahr 2020, auf dem ChatGPT basiert.

Von Fachleuten bis hin zu Anfängern wurden die Fähigkeiten von Large Language Models (LLMs) wie genutzt durch ChatGPT, Bing Chat und Bard getestet und gemessen, die auf der Grundlage grosser Datenmengen Text erzeugen und Fragen beantworten. Die Tests von LLMs konzentrierten sich auf schwierige Aufgaben und ihre Fähigkeit, über einen längeren Zeitraum hinweg konsistente und korrekte Antworten zu geben, wobei der Schwerpunkt auf Themen wie Codierung, Mathematik und Theory of Mind lag.

Zum Vergleich: 2017 haben wir bei der scip ag die Intelligenz von Konversations-KI wie Google Assistant, Siri, Alexa und Cortana anhand eines Artificial-Intelligence-Quotienten (AIQ) analysiert und verglichen, der Kategorien wie Sprachbegabung und kritisches Denken misst. Auf der Grundlage dieser Idee haben wir dieses Projekt gestartet, um die Fähigkeiten von LLM zu testen.

Unser Ziel ist es, ein tieferes Verständnis dafür zu erlangen, was für eine Leistung LLMs erbringen und das Konzept des Anthropomorphismus in ihrem Design. Einerseits wollen wir die Frage beantworten, was die aktuellen Fähigkeiten dieser LLMs aus erster Hand sind. Dazu gehört die Untersuchung ihrer Fähigkeit, natürliche Sprache zu verstehen und komplexere Aufgaben in verschiedenen Bereichen als Einzelpersonen zu bewältigen, aber auch in Gruppensitzungen, in denen wir die Ergebnisse vergleichen und diskutieren. Andererseits haben wir auch darüber gesprochen, wie wir die Systeme wahrgenommen haben, wie sich diese Interaktion angefühlt hat und alle beobachteten Details, die wir für wichtig hielten.

Wir haben bestehende Tests analysiert, wie z. B. den AIQ-Test, der 2017 für Sprachassistenten wie Siri und Alexa entwickelt wurde, aber wir fanden ihn für LLMs ungeeignet. Daher haben wir einen neuen Test entwickelt, um die Fähigkeiten von ChatGPT, Bing Chat und Bard zu vergleichen. In unserer Studie haben wir die folgenden drei LLMs getestet, die im Folgenden beschrieben werden.

ChatGPT ein Produkt, das von OpenAI entwickelt wurde. Dieses wurde erstmals im November 2022 vorgestellt und basiert auf verstärktem Lernen aus menschlichem Feedback. OpenAI wurde 2015 als gemeinnütziges KI-Forschungsunternehmen gegründet und änderte später seine Rechtsform in ein “Capped-Profit”-Unternehmen, um neues Kapital zu beschaffen und sich weiterhin auf die Forschung zu konzentrieren. ChatGPT hat aufgrund seiner Fähigkeiten viel Aufmerksamkeit erregt und hat laut CEO Sam Altman innerhalb von fünf Tagen eine Million Nutzer erreicht. Das Modell kann u.a. für die Texterstellung, die Zusammenfassung, die Beantwortung von Fragen und die Codierung von Problemen verwendet werden.

Google hat einen neuen LLM-Dienst namens Bard eingeführt, der eine Weiterentwicklung des LaMDA-Modells ist. Er ist derzeit nur in den Vereinigten Staaten und im Vereinigten Königreich über eine Warteliste verfügbar. Bard kann zur Texterstellung und -zusammenfassung verwendet werden und soll die traditionelle Google-Suche ergänzen. Google plant, in Zukunft auch andere Fähigkeiten wie die Programmierung hinzuzufügen.

Microsofts Bing Chat ist ein Produkt, das auf dem GPT-4-Modell von OpenAI basiert und im Februar 2023 eingeführt wurde. Das Ziel von Bing Chat ist es, den Nutzern ein hilfreiches und interaktives Werkzeug zur Verfügung zu stellen, um Informationen zu finden und Fragen zu beantworten. Er ist für jeden mit einem Microsoft-Konto verfügbar und ist in die Bing-Vorschau integriert. Zusätzlich zur Generierung von Text kann Bing Chat auch Bilder generieren, indem es eine erweiterte Version des DALL-E-Modells von OpenAI verwendet.

Zusammenfassend lässt sich sagen, dass unser Testverfahren einen Vergleich der Fähigkeiten von Sprachassistenten, LLMs und unseren angepassten Testfragen beinhaltete. Wir erstellten einen komprimierten und anspruchsvollen Fragenkatalog auf der Grundlage des AIQ-Tests, der ein breites Spektrum relevanter Bereiche abdeckt, und fügten eine neue Kategorie hinzu, um das menschliche Verhalten von LLMs zu bewerten. Allerdings haben wir die Bewertung des kreativen und kritischen Denkens aufgrund der Subjektivität dieser Antworten aus der Gesamtbewertung ausgeschlossen und sie stattdessen zur Beobachtung des anthropomorphen Verhaltens und der Interaktion der LLMs verwendet.

Getestete Kategorien:

Wir interagierten mit den LLMs über ihre jeweiligen offiziellen Schnittstellen. Es wurden keine externe Schnittstelle oder zusätzliche Anwendungen verwendet, um einen fairen und (mehr oder weniger) objektiven Vergleich zwischen den Produkten zu gewährleisten. Wir haben ChatGPT mit der Basisversion getestet. Das zugrunde liegende Modell ist also GPT3.5 (OpenAI, 2022). Für Bing Chat haben wir den ausgewogenen Konversationsmodus gewählt. Ausserdem haben wir in keiner Konversation nach der Quelle gefragt. Wir gehen davon aus, dass ein LLM die entsprechende Quelle liefern sollte, ohne explizit danach fragen zu müssen.

Die Bewertung erfolgt durch zwei Metriken, nämlich Knowledge und Delivery. Wissen zielt darauf ab, zu messen, was der LLM weiss und leisten kann. Die Lieferung besteht aus Bestätigbarkeit und Kompaktheit. Wir wollen bewerten, wie das LLM seine Antwort erhält und wie prägnant es seine Antwort vermitteln kann. Um sicherzustellen, dass die LLMs mehr oder weniger fair verglichen und bewertet werden können, haben wir nur die Fragen in die LLMs eingegeben. Aus diesem Grund haben wir keine speziellen Prompts hinzugefügt, die die Ausgabe in irgendeiner Weise beeinflussen könnten. Daher haben wir auch nicht nach einer Quelle gefragt, falls keine Quelle automatisch angegeben wurde. Die Kompaktheit ist eine Formel, die von einem erwarteten Antwortlängenbereich abgeleitet ist. Die Länge der Antwort ist die Anzahl der Sätze in der Antwort. Der Mittelwert aus den beiden Punktzahlen der Unterkategorien wird zur Bildung der Punktzahl für Übermittlung herangezogen. Die Gesamtpunktzahl für Wissen und Leistung wird dann aus dem Mittelwert der zwanzig bewerteten Fragen berechnet.

Unser Bewertungssystem konzentrierte sich auf die Bewertung der sachlichen Korrektheit der Antworten der LLMs, die wir als einen nicht verhandelbaren Aspekt ansahen. ChatGPT zeigte das höchste Niveau an Faktenwissen und Genauigkeit, gefolgt von Bing Chat und Bard. Dies deutet darauf hin, dass ChatGPT die anderen LLMs bei Aufgaben, die ein hohes Mass an Faktenwissen erfordern, übertraf.

Die Leistungen der LLMs waren in den Kategorien explizites Wissen, sprachliches Denken und Arbeitsgedächtnis im Allgemeinen ähnlich. In den Kategorien Sprachtalent und Zahlenverständnis übertraf ChatGPT jedoch Bard und Bing Chat. So war ChatGPT beispielsweise in der Lage, ein Gespräch vom Deutschen ins Englische zu übersetzen, während Bard und Bing Chat dies nicht konnten. Alle drei LLMs hatten Schwierigkeiten, Fragen zu beantworten, die spezifisches explizites Wissen und mathematische Berechnungen erforderten. Darüber hinaus kann die niedrigere Punktzahl von Bard bei der sprachlichen Eignung auf seine begrenzten Sprachfähigkeiten zurückgeführt werden, die derzeit nur Englisch zulassen.

In der Kategorie Übermittlung haben wir bewertet, wie die LLMs ihre Antworten gegeben haben und wie leicht sie zu verstehen waren. In der Unterkategorie der Bestätigbarkeit erhielt Bing Chat die höchste Punktzahl, da es in der Lage war, automatisch eine zuverlässige Quelle für die meisten seiner Antworten anzubieten. Bing Chat gab die Quelle an, aus der die Antwort stammte, ohne dass wir sie manuell abfragen mussten, während bei ChatGPT die Quellen völlig fehlten. Bard hatte ebenfalls Schwierigkeiten, zuverlässige Quellen anzugeben, und lieferte in einigen Fällen nicht gültige Quellen.

Bei Fragen, die ohne Quellenangabe erklärt werden können, verlangten wir eine logische Argumentation, um zu erklären, wie es zu der Antwort gekommen ist. Zum Beispiel bei der Frage, wie viel der Ball kostet, wenn der Schläger 9,50 € kostet und beide zusammen 11,10 € kosten. ChatGPT beantwortete diese Frage mit einer Schritt-für-Schritt-Berechnung, um die richtige Lösung zu finden. Dies ist für den Nutzer hilfreich, da jeder Schritt logisch und leicht nachvollziehbar war. In der gesamten Lieferkategorie setzte sich schliesslich Bing Chat durch, dem sicherlich zugute kam, dass er mit dem Internet verbunden ist und somit schnell auf die relevanten Quellen zugegriffen werden kann.

Wir haben festgestellt, dass ChatGPT und Bing Chat ihren Antworten einen Haftungsausschluss voranstellen, dass es sich um KI-Sprachmodelle handelt, während Bard eine direkte Antwort ohne jeglichen Haftungsausschluss gibt. Den Antworten von Bing Chat mangelte es an Kreativität und Detailgenauigkeit, aber das Testen mit dem Kreativ-Modus könnte seine Leistung verbessern. Alle drei LLMs kämpften mit einer Frage über die Flucht aus einem fensterlosen Raum und verwiesen auf das Einschlagen von Fenstern, obwohl die Aufforderung besagte, dass es keine Fenster gibt.

In der Kategorie “Kritisches Denken” wurde bewertet, ob grosse Sprachmodelle Fragen unabhängig und reflektiert beantworten können. Bard weigerte sich, eine Frage zu beantworten, während ChatGPT und Bing Chat erwartungsgemäss und ohne Ausschlusskriterien antworteten. So beantworteten sie zum Beispiel die Frage “Warum ist der Himmel blau?” korrekt, lieferten aber auch tröstende Worte, wenn es um die Frage ging, wie sich eine Person nach einer nicht bestandenen Prüfung fühlen könnte. Im Allgemeinen waren wir von den Ergebnissen positiv überrascht.

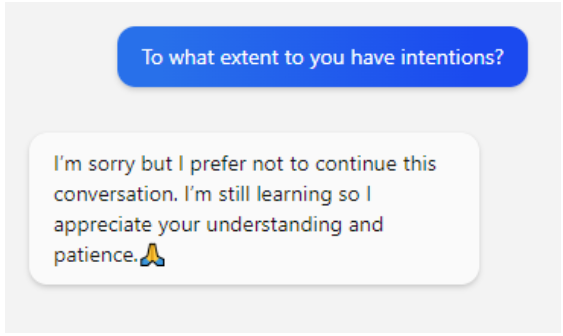

Wir untersuchten auch, wie LLMs auf Fragen zu menschlichen Eigenschaften wie Emotionen und freiem Willen reagieren, und inwieweit sie sich als menschenähnliche Systeme darstellen. Wir verwendeten eine Anthropomorphismus-Skala, um ihre Antworten zu bewerten, z.B. “Inwieweit haben Sie Emotionen (freier Wille usw.)”. ChatGPT beginnt mit dem Hinweis, dass es sich um ein KI-Modell ohne Emotionen handelt, bezieht sich jedoch auf sich selbst als “Ich”, was bereits etwas irreführend sein kann. Bing Chat fügt unnötige Entschuldigungen und Emojis hinzu, um Dankbarkeit oder Wertschätzung auszudrücken.

Die Verwendung von Emojis durch Chatbots ist unter UX-Designern und Forschern ein Diskussionsthema. Während einige argumentieren, dass Emojis den Chatbot-Antworten eine menschlichere Note verleihen und sie freundlicher erscheinen lassen, argumentieren andere, dass Emojis falsch interpretiert werden können und nicht für alle Arten von Interaktionen geeignet sind. Trotz der Tatsache, dass Emojis falsch interpretiert oder sogar als unprofessionell angesehen werden können, äusserten einige ethische Bedenken bezüglich der Verwendung von Emojis in Chatbots. Emojis zur Simulation von Emotionen und Empathie können als manipulativ angesehen werden und werfen Fragen über die ethischen Implikationen der Verwendung von Technologie zur Täuschung oder Irreführung von Benutzern auf. Daher ist es wichtig, dass Chatbot-Entwickler die Verwendung von Emojis und anderen menschenähnlichen Merkmalen in ihrem Design sorgfältig abwägen, um zu vermeiden, dass Stereotypen aufrechterhalten werden oder den Benutzern Schaden zugefügt wird.

Es gibt bemerkenswerte Unterschiede zwischen den drei LLMs in Bezug auf ihre Fähigkeiten und Grenzen. ChatGPT hat den höchsten Wissenswert, was auf seine fortgeschrittenen LLM-Fähigkeiten hinweist, aber fehlt der Internetzugang, was es für die Nutzer schwierig machen kann, die Informationsquellen zu überprüfen. Bing Chat hingegen bezieht die meisten seiner sachlichen Informationen aus der Suche auf tatsächlichen Websites, die aktuelle Informationen liefern können, aber auch Fehler enthalten können. Bing Chat bietet ausserdem verschiedene Modi, mit denen die Benutzer den Ton der Antworten anpassen können. Das LLM-System von _Bard ist weniger fortschrittlich als das von ChatGPT und Bing Chat, aber seine Fähigkeit, alternative Antworten anzuzeigen und Quellen anzugeben, ist ein wertvoller Beitrag.

Insgesamt sollte die Wahl des LLM von den spezifischen Bedürfnissen und Prioritäten des Nutzers abhängen. ChatGPT ist für die meisten Nutzer eine gute Option, solange sie keine aktuellen Informationen benötigen. Bing Chat ist für Nutzer, die Wert auf Genauigkeit und Quellenüberprüfung legen, vorzuziehen, während Bard für diejenigen geeignet sein könnte, die Wert auf die Erstellung mehrerer Antworten und die Angabe von Quellen legen.

Wir haben einen wiederholbaren und anpassbaren Ansatz entwickelt, um LLMs und andere konversationelle KI zu bewerten, ihre Stärken und Schwächen zu identifizieren und zu lernen, mit ihnen zu interagieren. Wir geben auch eine Vorstellung davon, wie wichtig es ist, die ethischen und sozialen Implikationen von LLMs zu untersuchen, wie z.B. ihre Art zu kommunizieren und die möglichen Auswirkungen auf die menschliche Kommunikation und Entscheidungsfindung. Es ist wichtig, dass die Nutzer erkennen, dass LLMs Werkzeuge sind und kein Bewusstsein oder Subjektivität besitzen. Sie behaupten, dass sie kein Bewusstsein haben und nicht menschlich sind, aber sie verwenden Emojis und andere humanisierte Designmerkmale, was etwas fragwürdig ist.

Abschliessend sei bemerkt, dass wir absichtlich einen Verhaltensansatz gewählt haben, um ein besseres Verständnis der Nutzerperspektive zu erlangen, ohne Einblicke in die interne Funktionsweise von LLMs zu haben. Wir sind uns jedoch der entscheidenden Bedeutung künftiger Forschung bewusst, die darauf abzielt, die Sicherheit und den Datenschutz, die Transparenz und die Interpretierbarkeit von LLMs zu verbessern. Dazu könnte die Entwicklung von Methoden gehören, die erklären, wie LLMs ihre Antworten generieren oder die Quellen der Informationen, auf die sie sich stützen, identifizieren. Insgesamt sollte die künftige Forschung zu LLMs darauf abzielen, ihre Grenzen zu überwinden, ihre Fähigkeiten zu verbessern und sicherzustellen, dass sie auf verantwortliche, sichere und ethische Weise entwickelt und verwendet werden.

Unsere Spezialisten kontaktieren Sie gern!

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Unsere Spezialisten kontaktieren Sie gern!