Ist das Kunst? Persönliche Reflexionen über meine KI-Kunstwerke

Marisa Tschopp

Der erste Teil der Serie Die Psychologie Künstlicher Intelligenz, widmet sich dem äusserst komplexen Thema Kognition (geistige Aktivität) und welche Parallelen zur künstlichen Intelligenz bestehen. Die Faszination am Mensch-Maschine Vergleich war von Anbeginn ein wesentlicher Bestandteil jener Diskurse, von der Wissenschaft über die Wirtschaft zum alltäglichen Leben: Von der Dampfmaschine über den Taschenrechner bis zum humanoiden Roboter.

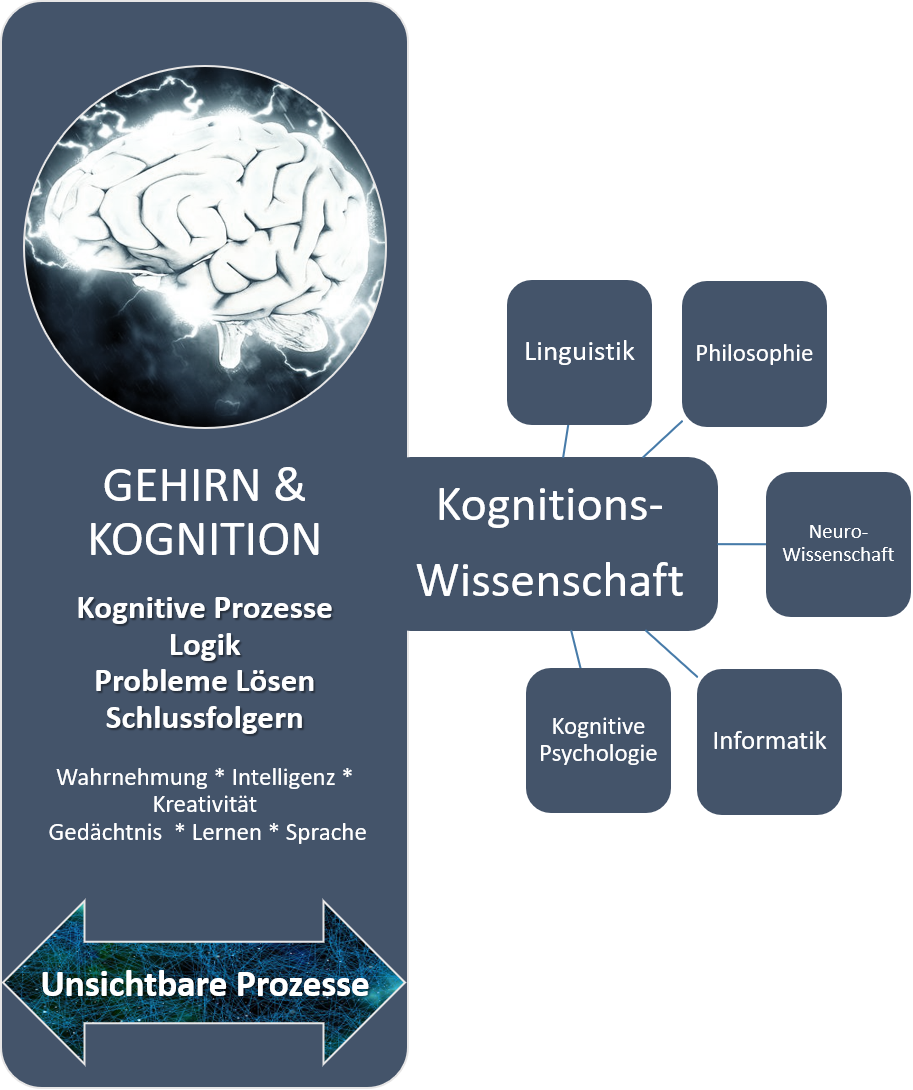

Das Thema Kognition umfasst etliche Sub- und angrenzende Gebiete und kann von Seite der Psychologie, Biologie oder Medizin und weiteren Disziplinen, wie Philosophie oder Neurowissenschaft untersucht werden. Der vorliegende Artikel versucht einen integrativen Überblick über den Stand der Forschung im Bereich Kognition und KI zu geben. Er streift historische Entwicklungen ebenso wie relative, realistische Prognosen, stets unter dem Paradigma der Wissenschaftlichkeit.

Ganze Studiengänge befassen sich jahrelang mit nur einem Subgebiet der Kognitionswissenschaften, wie z.B. die Erforschung des Gehirns oder der Entwicklung und Verwendung von Sprache. Es gibt eine Vielzahl an Forschungsfragen, die sich dem Zusammenspiel von Gehirn, geistigen Prozessen, Verhalten und Umwelt widmen. So kann beispielsweise, durch die Betrachtung der biologischen, neuronalen Ausstattung, die Frage nach der Einzigartigkeit der menschlichen Spezies, zumindest zum Teil beantwortet werden. Der Wunsch, Gründe und Abgründe unterschiedlicher Verhaltensweisen zu entschleiern, Regeln aufzustellen und Prognosen für künftige Verhaltensweisen zu postulieren, ist im menschlichen Dasein seit jeher tief verwurzelt. Dies zeigen schon die Schriften aus der Antike, von den grossen Denkern wie Aristoteles, Seneca oder Sokrates. Während im Mittelalter eine durch Religion geschürter “Einbruch im Denken” vorherrschte, so hat im 16./17. Jahrhundert, das rationale Denken und die Wissenschaft wieder Einzug in die Gesellschaft gehalten und die Epoche der Aufklärung geprägt. Während allerdings Aristoteles durch subjektive Verfahren, wie Introspektion und Diskussion auf Ergebnisse kam, haben Forscher im 21. Jahrhundert, dank der technischen Errungenschaften, objektive und systematische Verfahren zur Daten- und Wissensgenerierung entwickelt. Die empirische Sozialforschung, einhergehend mit bis dato ungelösten Kontroversen und Methodenstreitigkeiten, wurde geboren.

Trotz der Kontroversen oder gerade deshalb, wurden weitreichende Fortschritte erzielt: In bildgebenden Verfahren, wie zum Beispiel mithilfe der Positronen-Emissions-Tomographie (PET), haben Forscher die Möglichkeit, echte (objektive) Einblicke in die “Black Box”, also die von aussen unsichtbaren Vorgänge in Gehirn und Nervenzellen, zu gewinnen. Die Grundidee ist dabei immer die Gleiche: Es gibt einen Reiz, ein Autofahrer sieht eine rote Ampel; und eine entsprechende Reaktion, der Autofahrer hält an. Die Kognitionsforschung versucht mit solchen Verfahren zu erklären, welche kognitiven Prozesse ablaufen, die zur Reaktion “Anhalten” führen.

Zimbardo & Gerrig (2007) sehen die künstliche Intelligenz (im Rahmen der Informatik) als ein Teilgebiet der Kognitionswissenschaften. Die verschiedenen Strömungen der Kognitionswissenschaften, wie zum Beispiel Neurowissenschaft oder Linguistik, haben grosse Einflüsse auf die KI Forschung, da eine KI (unabhängig, ob starke oder schwache KI) diese geistigen Prozesse nachahmen will, von der Spracherkennung bis zu der Fähigkeit, komplexe Gespräche zu führen. Somit ist es nur allzu logisch, diese Prozesse beim Menschen verstehen zu wollen und Technologien zu entwickeln, die diese Regeln und Reaktionsmuster ausführen können. Hier hat IBM grosse Pionierarbeit geleistet und die Ära des Cognitive Computing eingeläutet. Dabei kommt eine Form der Informationsverarbeitung, das maschinelle Lernen mittels Deep Learning, als Ausprägung künstlicher Intelligenz zum Tragen.

Hier sorgen bereits einige begriffliche Unklarheiten für erste Verwirrungen. Welcher Begriff und welche Definitionen in welcher Form vorherrschen werden, wird sich noch zeigen. Laut dem aktuellen AI Report der Stanford University, sorgen jedoch gerade diese ungeklärten Definitionen für die bemerkenswerte Aufmerksamkeit, die KI erhält.

Während Philosophie und Linguistik als Teil der Kognitionswissenschaften historisch gesehen eine lange Geschichte bis in die Antike haben, so ist die Informatik (im englischen Sprachraum Computational Sciences) forschungstechnisch gesehen mit weniger als 80 Jahren relativ jung. Allerdings wird dieser “Vorsprung” nicht lange einen Unterschied machen. Die Informatik wird eine unanfechtbar starke Stellung in der formalen Ausbildung erhalten: Schnelle Informationsverarbeitung und Austausch, steigende Anzahl an Daten und die damit einhergehende rapide Weiterentwicklung der Theorie und Anwendungsfälle, als auch die immer stärker werdende interdisziplinäre Ausrichtung der Forschungsanstalten, werden dafür sorgen. Ein Nachteil dieses unorganischen Wachstums ist der Information Overload, der in den kommenden Jahren nur durch aufwendige Metaanalysen zu bewältigen sein wird. In den nächsten fünf bis zehn Jahren können klare Definitionen und Abgrenzungskriterien erwartet werden. Hier könnten intelligente Programme einen wertvollen Beitrag leisten, da die Unmenge an Informationen in den unterschiedlichsten Formaten, wie wissenschaftliche Journals oder Blogs, kaum zu bewältigen ist.

Die Stanford Universität arbeitet seit 2009 am Thema KI und erklärt im aktuellsten Bericht (2016), dass die folgenden technologischen Eckpfeiler zur KI Forschung gehören:

Sie identifiziert acht unterschiedliche Wirkungsstätten, auf die die KI mittles der oben genannten Kernbereiche massgeblich Einfluss hat. Diese sind:

Die Komplexität liegt an den Schnittstellen zwischen gesellschaftlichen und technischen Forschungsfragestellungen, denn diese sind hier tief ineinander verwoben.

Ein grosse Gefahr ist die durch die Komplexität begründete “try now, regret later” Einstellung. Gesellschaftliche oder ethische Fragestellungen sind von Natur aus schwierig, Ressourcen für solche Themen sind knapp. Der gesellschaftliche Imperativ nach Fortschritt und schnellem Erfolg verleitet zur Vernachlässigung von gesellschaftskritischen Implikationen und verschiebt die Frage nach der Verantwortungsverteilung in die Zukunft. Insofern, sind die omnipräsenten Rise-of-the-Robots Prophezeiungen auch nützlich als dass sie, wenn auch übertrieben, zumindest auf gewisse Gefahren hinweisen. Einen möglichen Weg geht die IEEE Organisation, welche eine globale Initiative für ethische Richtlinien Intelligenter und Autonomer Systeme zum Wohl der Menschheit vorschlägt. Die Ethik erhält in der formalen Bildung leider nicht immer die Aufmerksamkeit, die von Nöten wäre, jedoch ist ein deutlicher Aufschwung erkennbar.

Die Frage lautet: zu welchem Zweck? Was soll KI eigentlich können? KI soll helfen menschliche Probleme zu lösen. Zum Beispiel: Wie schafft es Facebook mit nur 20’000 Sicherheits-Mitarbeitern, die Sicherheit und Integrität von 1.3 Milliarden Usern zu wahren? Ein grosses weltbewegendes Problem, das u.a. mit KI gelöst werden könnte.

Bei der Entwicklung einer Lösung kann die Untersuchung der geistigen Prozesse und Komponenten, mit denen Menschen sprechen oder Probleme lösen, einen wertvollen Beitrag leisten. Die kognitive Psychologie untersucht parallele und serielle Prozesse und unterscheidet dabei auf den Ebenen der Aufmerksamkeit, automatische und kontrollierte Prozesse. Das Thema Problemlösen und Logik wird in diesem Bericht genauer betrachtet. Sprachproduktion und Verwendung wurde bereits diskutiert. Die Themen Gedächtnis, Intelligenz und Kreativität gehören auch in das Gebiet der kognitiven Psychologie, werden jedoch aufgrund ihrer Vielschichtigkeit in kommenden Forschungsarbeiten separat behandelt.

Welche geistigen Prozesse von statten gehen, wenn ein Autofahrer eine rote Ampel sieht und daraufhin anhält, sind Gegenstand der Kognitionsforschung. Genau dass es “im Kopf” stattfindet und nicht direkt sichtbar ist, macht das Thema so reizvoll. Im 19. Jahrhundert wurde mit F.C. Donders Experiment zur Messung der Geschwindigkeit geistiger Prozesse der Grundstein kognitiver Theorien gelegt. Mit einem Paper-Pencil-Test, in dem eine Versuchsperson eine Reiz- und/oder Reaktionsauswahl treffen musste, wurde das Fundament zur Theoriebildung gelegt: Unterschiedliche geistige Prozesse benötigen unterschiedliche Reaktionszeiten.

Reizklassifikation: Malen Sie ein C über alle gross geschriebenen Buchstaben:

Sein odEr NicHt sEin, dAs iSt hiEr Die FRaGe [. WaS…]

Reizklassifikation plus Reaktionsauswahl: Malen Sie ein V über alle gross geschriebenen Vokale und ein C über alle gross geschriebenen Konsonanten:

Sein odEr NicHt sEin, dAs iSt hiEr Die FRaGe [. WaS…]

Die zweite Aufgabe dauert in der Regel länger als die erste. Diese Form der psychometrischen Tests führt zur Hypothese, dass Prozesse parallel als auch seriell ablaufen können. Je nachdem wie viele geistige Ressourcen benötigt werden, kann dies mit einem bestimmten Mass an Sicherheit (unter Beachtung der Fehlerquote) mit experimentellen Tests bestimmt werden. Eine grundlegende Moderatorvariable sind Aufmerksamkeitsprozesse. Sie beeinflussen Verarbeitungsressourcen massiv. Beispielsweise können Navigationsressourcen (langsames Gehen) und Sprachprozesse parallel ablaufen. Wird die Aufmerksamkeit jedoch auf ein interferierendes Ereignis gelenkt, wie zum Beispiel Glatteis auf der Strasse, ist es schwierig das Gespräch weiterzuführen. Anders verhält es sich beim Autofahren, obwohl es wie das Laufen ein Navigationsverfahren ist, sind hierbei deutlich mehr Prozesse parallel am Wirken (schalten, lenken, Verkehr, etc.), sodass parallellaufende Sprachprozesse kontraproduktiv sind und sich negativ auf die mentalen Ressourcen auswirken. An diesem Vergleich wird ebenso eine weitere Dimension geistiger Prozesse deutlich: Es wird differenziert, ob diese kontrolliert ablaufen und ein hohes Mass an Aufmerksamkeit benötigen oder automatisch, ohne erforderliche Aufmerksamkeit. Geradeauslaufen ist für fast alle Menschen ohne Behinderung ein automatisierter Prozess; Autofahren zeigt hingegen erhebliche Unterschiede auf, je nach Erfahrung des Fahrers. Automatisierte und kontrollierte Prozesse, sind also keine dichotome Klassifizierung, sondern abhängig von der Anzahl an erlebten Interferenzen.

Mehr als nur eine Interferenz besteht, wenn ein Zielzustand aus irgendeinem Grund gar nicht erreicht werden kann. Die Person steht vor einem Problem. Hierbei bündeln sich mentale Prozesse auf einen Zielzustand, wobei sich aktuelle und im Gedächtnis befindliche Informationen verbinden. Eine Form des Problemlösens ist das logische Denken, bei dem entweder induktive oder deduktive Schlussfolgerungen gezogen werden.

Alle Probleme, unabhängig von ihrer Komplexität, haben eines gemeinsam: Ihnen liegen fehlende Informationen zu Grunde. Diese gilt es zu finden, um das Problem zu lösen. Aus dieser Anfangssituation heraus gilt es, mithilfe sich von einer Menge an Schritten zum Zielzustand zu bewegen; diese drei Elemente definieren den Problemraum. Um ein Problem zu lösen, muss analysiert werden, wie klar der Anfangs- und Zielzustand definiert ist, um dann die Schritte zum Zielzustand zu bestimmen. Ist ein Anfangs- und Zielzustand klar definiert, kann ein Algorithmus verwendet werden, ein Verfahren, dass bei einem spezifischen Problem stets zur richtigen Lösung führt, beispielsweise um die Kombination eines Zahlenschlosses herauszufinden. Da allerdings Probleme und Lösungen nicht immer klar und Ressourcen knapp sind, wenden Menschen zusätzlich Heuristiken an, eine Art Simplifizierung des Denkens.

Untersucht wurden diese Denkvorgänge mithilfe der Methode des lauten Denkens, in der Versuchspersonen, zum Beispiel beim Lösen eines Rätsels, ihre Denkschritte so genau wie möglich aussprechen sollen. Mittels dieser Verbalisierung werden Einblicke in die unterschiedlichen Prozesse des Problemraums und dessen Komplexität gewonnen. Gleichermassen hat schon Aristoteles sich damit beschäftigt, wie man mittles diverser Aussagen innerhalb eines Problemraums zu einer logischen, richtigen Schlussfolgerung kommt. Dabei nehmen diese Denkprozesse, genannt deduktives Schliessen, die Form eines Syllogismus an. Das bedeutet, dass mindestens zwei Aussagen zu einer Schlussfolgerung führen (Vergleiche Zimbard & Gerrig, 2008):

| Prämisse 1 | ∧ | Prämisse 2 | ⇒ | Schlussfolgerung |

|---|---|---|---|---|

| Das Restaurant akzeptiert alle wichtigen Kreditkarten | ∧ | Visa ist eine wichtige Kreditkarte | ⇒ | Das Restaurant akzeptiert Visa |

Viele Probleme können in die Form von Syllogismen gebracht werden. Allerdings ist hier Vorsicht geboten: Beurteilungsschwächen, pragmatische Schlussfolgerungen und kulturelle Unterschiede in der Erfahrungsumwelt führen zu Fehlschlüssen. Während beim deduktiven Schliessen die Gültigkeit von Informationen im Vordergrund steht, wird beim induktiven Schliessen, eine andere Form des logischen Denkens, eine Schlussfolgerung anstatt auf 100%er Gewissheit auf Basis von Wahrscheinlichkeiten gezogen. Diese Wahrscheinlichkeit sollte offengelegt werden, indem die Antwort “vermutlich” oder ähnliche Wörter enthält.

Zusammenfassend kann festgehalten werden, dass bei der Deduktion vom Allgemeinen auf das Einzelne gefolgert wird, und dies mit 100%er Gültigkeit. Bei der Induktion wird von der Empirie (Daten oder Beobachtung), also vom Einzelnen auf die Allgemeinheit geschlossen, wodurch mit einer bestimmten Wahrscheinlichkeit richtige Aussagen getroffen werden können. Ein dritter Weg ist die Abduktion, eine Form der Logik, die mit erheblichen Fehlerrisiko ursächliche Schlussfolgerungen zieht. In der Wissenschaftstheorie, spielen diese Formen der Logik eine grosse Rolle und sind Schauplatz für philosophischen Auseinandersetzungen, die seit dem ersten Aufkommen der Logik von Aristoteles noch lange nicht gelöst sind. Der berühmte Erkenntnistheoretiker Karl Popper lehnte die Induktion vollends ab und begründete das Prinzip der Falsifizierung. Der Falsifikationismus versucht nach dem Trial-and-Error Prinzip eine Hypothese unentwegt zu falsifizieren, nur so kann die “die einzig wahre Wahrheit” gefunden werden.

Es gibt als viele Wege, die ein Problem lösen. Die Logik hinter der Logik ist komplex und eine Königsdisziplin des Homo Sapiens. Seit der Nutzung von Gerätschaften, wie Pfeil und Bogen vor ca. 70.000 Jahren während der kognitiven Revolution, und der Erlangung der Fähigkeiten zur Gruppenorganisation und Kommunikation, begann die Dominanz des Homo Sapiens gegenüber anderen Spezies, wie beispielsweise den Neandertalern (Harari 2015). Dank der wissenschaftlichen Revolution wurden diese “Gerätschaften” immer ausgefeilter und effizienter, was uns zum heutigen Zeitpunkt bringt: Eine Gesellschaft im steten technologischen Wandel, mit all ihren Errungenschaften, von der ersten Tabelliermaschine um 1900 herum, bis zu allgegenwärtigen Sprachassistenten wie Amazon’s Alexa und ausgefeilten Programmen, wie IBM’s Watson und AlphaGo von Deepmind. Aus Betrachtung der historischen Entwicklung, der Einflüsse der Forschung, wird die Bedeutung der KI für unsere Zukunft unanfechtbar (vermutlich!).

Die Unmenge an unwissenschaftlichen Artikeln und Videos zum Mensch-Maschine Vergleich verleiht dem Thema nicht selten einen faden Nachgeschmack. Doch es gibt Möglichkeiten Licht ins Dunkle zu bringen, solange Wissenschaftlichkeit, Objektivität und Legitimierung im Fokus stehen. Die Eckpfeiler einer solchen Bestrebung müssen also theoretisch fundiert sein, evidenzbasiert und einen Sinn haben. Jeder Mensch, der sich nur ein bisschen mit dem Thema KI auseinandersetzt, muss sich fragen: Zu welchem Zweck? Die Legitimierung ist allein schon dadurch gegeben, dass dem Hype um die Untergangsfantasien durch Vernunft Einhalt geboten werden muss.

Ein möglicher systematischer Vergleich sieht wie folgt aus: Die wesentlichen Elemente belaufen sich auf (1) die Reizklassifizierung, also die Art des äusserlichen Reizes, (2) das Zugangssystem, wodurch der Reiz wahrgenommen wird, (3) die inneren Prozesse der Informationsverarbeitung und die (4) Ausgangsgestaltung, also das Format der Reaktionsüberlieferung. Folgend wird für jede Dimension ein kurzer, beispielhafter Einblick gegeben, es gibt selbstverständlich noch weitere Optionen.

Bei der Reizklassifizierung geht es um die Frage, wie der Reiz charakterisiert werden kann. Dies wird über die fünf Sinne definiert. Der Mensch verfügt über fünf Aussensinne, welche Reize klassifizieren: Tasten, Hören, Sehen, Riechen und Schmecken.

Am Beispiel Touchscreen versus Sprachsteuerung soll veranschaulicht werden, wie die natürliche Kommunikation bei Maschinen noch in den Kinderschuhen steckt, trotz der technischen Fortschritte: Während ein Berührungsreiz mittels Touchscreen mittlerweile fest etabliert ist, so ist aktuell Sprache schon relativ weit, allerdings kulturell noch nicht fest etabliert. Ein natürlicher Umgang mit Sprachsteuerung von Geräten muss sich noch entwickeln. Hier gilt es über Role Models und Early Adopters den Prozess zu normalisieren. Hot-topic in der Forschung sind visuelle Reize. Innovationstreiber sind hier die Möglichkeiten in der medizinischen Diagnostik. Hier ist die Forschung, Entwicklung und Umsetzung in der Praxis relativ weit.

Riechen und schmecken sind noch in der Erforschungsphase, aber die Möglichkeiten des Gebrauchs sind vielversprechend und nicht unrealistisch. Zum Beispiel könnte ein privates mobiles Endgerät anhand der Zusammensetzung der Moleküle erkennen, ob eine Erkältung im Anmarsch ist (anhand des Atems) oder ob die gerade geöffnete Weinflasche korkt. Ein weiteres Anwendungsfeld ist auch die Erkennung von Gas oder Giften.

Im Alltag spielt das Zugangssystem vor allem dann eine Rolle, wenn es die Mensch Maschine Interaktion (HMI) entscheidend beeinflusst, wie zum Beispiel ein gutes Mikrophon zur Spracheingabe. Dort gibt es signifikante Unterschiede, die beim Menschen nur aufgrund von Alter oder Krankheit differenzieren. Am Beispiel des menschlichen Auges wird deutlich, dass die Entwicklung von Kameras sich wiederum am Vorbild der Menschen bedient hat und diese erfolgreich nachgeahmt hat: Die Blende einer Fotokamera ist der Iris des menschlichen Auges nachempfunden, um die Lichtverhältnisse bestmöglich anzupassen. Der Mensch-Maschine Vergleich hat also auch hier zu erheblichen Forstschritten geführt.

Ein intaktes, hervorragendes Zugangssystem ist eine notwendige, aber nicht ausreichende Voraussetzung für eine hochentwickelte Maschine mit einer starken oder schwachen “Intelligenz”. Keiner würde eine handelsübliche Kamera als intelligent bezeichnen, denn das wirklich spannende Element ist das, was den Bildern letztlich Bedeutung verleiht; und das geschieht im Gehirn.

Die inneren Prozesse sind das Herzstück des Mensch-Maschine Vergleichs, da hier die “magischen” Dinge passieren. Alles, was nach aussen hin nicht klar mit Daten beschrieben werden kann, lässt Raum für Spekulation, Diskussion und Konkurrenz. Ein neuer Aufschwung hat der Mensch-Maschine Vergleich durch den publikumswirksamen Supercomputer Watson (IBM) erhalten, der selbst die weltbesten Jeopardy Spieler bezwungen hat. Technologische Innovationen wie die Künstlichen Neuronalen Netze als Teil des maschinellen Lernens hielten Einzug. In Kürze zusammengefasst: Künstliche Neuronale Netzwerke sind inspiriert von dem Aufbau des menschlichen Gehirns. Inspiriert, mehr auch nicht. Denn wie das Gehirn funktioniert, weiss die Forschung noch lange nicht.

Dass hier allerdings ein grosses Potential liegt, haben Wissenschaft und Wirtschaft schnell verstanden und umgesetzt. 2005 entstand das Human Brain Project (ehemals Blue Brain), welches nach derzeitigem Stand (EPFL, Lausanne/ Genf, 2005 – 2018) einen sehr kleinen Teil eines Rattenhirns mittels künstlichen Neuronen nachbauen konnte. Eine Sensation, eine Milliarden Ausgabe mit dem derzeit leistungsfähigsten Supercomputer der Welt, und grosse Hoffnungen einst das menschliche Gehirn zu entschlüsseln, um damit Krankheiten wie Parkinson heilen zu können.

Wer befruchtet hier nun wen? Die Technologie als auch das Wissen um das Gehirn haben beide bemerkenswerte Fortschritte erzielen können. Es darf allerdings keinesfalls angenommen werden, dass synthetisch hergestellte Neuronen, wie sie ähnlich auch bei KI zum Einsatz kommen, auch nur in die Nähe der Fähigkeiten menschlicher neuronaler Netzwerke kommen; Im Übrigen, arbeiten rund 130 Forscher an diesem internationalen Leuchtturmprojekt und können derzeit eine kortikale Säule einer Ratte mit etwa 30’000 Neuronen rekonstruieren. Im Vergleich dazu hat ein menschliches Gehirn vermutlich 100’000’000’000 Neuronen und der Energieverbrauch dafür würde dutzende Supercomputer also auch Dutzende Milliarden verschlingen.

Wendet man sich wieder dem Vergleich KI und Mensch zu, so kann festgehalten werden, dass es sich bei den Künstlichen Neuronalen Netzen zwar nur um eine Abstraktion handelt, jedoch kann dieses Verfahren beim maschinellen Lernen und komplexen Problemen grössere Erfolge in Anwendungsgebieten wie der Bild- und Mustererkennung verbuchen (weitere Anwendungsgebiete in der Sprach,- Schrifterkennung, Frühwarnsysteme, Robotik uvm.). Besonders publikumswirksam sind aber die Ergebnisse einer KI (mit künstlichen neuronalen Netzwerken), die in Spielen wie Schach, Jeopardy oder Go bessere Ergebnisse als Menschen erzielen.

Bezogen auf die oben genannten, unterschiedlichen geistigen Prozesse steht fest, dass eine ähnlich starke parallele Verarbeitung noch unmöglich ist. Nach derzeitigem Stand der Anwendung ist hauptsächlich serielle Informationsverarbeitung umsetzbar. Will man noch die menschlichen kontrollierten versus automatisierten Prozesse vergleichen, so gibt es verschiedene Betrachtungsweisen. Jedoch ist offen, welche dabei Sinn machen. Kontrollierte Prozesse könnten Prozesse sein, die besonders viel Energie benötigen, wenn dabei Energie mit der menschlichen Aufmerksamkeit gleichgesetzt wird. Eine alternative Möglichkeit wäre, den Vergleich auf Basis der Entwicklung anzusetzen, so dass ein Prozess, der (noch) viel menschlichen Input benötigt, nicht automatisch abläuft. So könnte man die automatischen, kognitiven Prozesse mit selbstlernenden Algorithmen vergleichen. An dieser Stelle wäre vielleicht ein Vergleich aus Perspektive des menschlichen Lernverhaltens gewinnbringender. Beim Thema Lernen ist auch wieder die Frage nach dem strukturellen Aufbau interessant, die sowohl physiologische als auch philosophische Aspekte enthält: Die Idee vom modularen Aufbau des menschlichen Gehirns (vgl. hierzu die Broca-Areale) bietet ausreichend Stoff für hitzige Diskussionen.

Des Weiteren ist die Frage nach der Entscheidungsfindung aufgrund von Heuristiken und Wahrscheinlichkeitsrechnung ein bedeutendes Thema. Was die Basis- oder Schwellenwerte sind, wer diese festlegt und wer die Verantwortung dafür trägt, wenn es zu fundamentalen Resultaten kommt ist äusserst heikel (im Medizinen Bereich oder Transportsystem beispielsweise). Weniger tiefgreifende Folgen, hat die Festlegung von Schwellenwerten für eine Entscheidung z.B. bei Wissensfragen. Im aktuellen Forschungsprojekt der scip AG werden digitale Assistenten auf ihre kognitiven Fähigkeiten als eine Dimension von Intelligenz untersucht. Bei einem Test mit Amazon’s Alexa antwortet Alexa auf eine Wissensfrage mit “vermutlich”, wenn etwas noch weiterer Recherche bedarf. Diese Bekenntnis der Unsicherheit ist nicht nur hilfreich, um Einblick in die Funktionsweise zu erhalten, sondern auch zur Philosophie und Logik der Übermittelung von Daten (vergleicht man hierzu die Idee des induktiven Schliessens).

Zuletzt kann die Gestaltung des Outputs als Vergleichsdimension betrachtet werden. Auch hier gibt es wieder etliche Ebenen und Blickwinkel, wie die verarbeitete Information, der Zielzustand kommuniziert wird. Beim Menschen werden wie beim Zugangssystem, wieder die Ebenen der fünf Sinne relevant. In Bezug auf die Interaktion, ist die Sprache, inklusive Mimik und Gestik, sicher eines der wichtigsten Kriterien. Auch die Messung weniger sichtbare Reaktionen, wie zum Beispiel die Messung des Hautwiderstandes, ein klassisches Mittel der Werbewirksamkeit, wird in der Forschung angewendet. Hier wird die Reaktion auf unterschiedliche Bilder gemessen, was relevant ist bei der Entscheidung, ob für eine Getränkewerbung eher ein Landschaftsbild oder eine Gruppe von Menschen wirksamer ist. Diese und andere Erkenntnisse aus der Markt- und Werbepsychologie werden vor allem in der konkreten Anwendung von KI relevant, z.B. in humanoiden Robotern als Service Assistent oder Sprachassistenten wie Alexa, die nicht nur zu Hause sondern auch im beruflichen Kontexten immer mehr Einsatz findet. Von der Form, Grösse, Farbe, Stimmfarbe, Akzent, Gender, mit Bildschirm oder ohne, sind bis ins kleinste Detail Fragestellungen denkbar. Diese sind nicht nur ein künstlerisch-kreativer Aspekt, vor allem aber auch ein erfolgskritischer; denn ein Fehler, bei Missachtung von Gender- oder Rassenzuordnungen, kann zu massiven Imageverlusten oder juristischen Problemen führen.

Auch beim Aufbau von Vertrauen, spielt die Ausgangsgestaltung eine grosse Rolle. Hier können die Ergebnisse aus der langjährigen, evidenzbasierten psychologischen Forschung, rund um das Thema Wahrnehmung, Urteilen und Urteilsverzerrung/ Bias, Entscheidungsfindung, einen wertvollen Beitrag leisten. Am Beispiel des Konzepts “Vertrauen”, sind unterschiedliche Versuchsdesigns möglich, wobei Vertrauen sowohl unabhängige (Ursache), abhängige (Wirkung) also auch moderierende Variable darstellen kann. Eine interessante Fragestellung könnte dabei die Rolle einer bestimmten Form des Primings, auf den Vertrauensaufbau zum User sein; oder welche Variablen der äusseren Form zu Reaktanz führen. Faktoren rund um das Thema Kultur, Gender, usw. sind wichtige Kontextvariablen.

Dem Einfallsreichtum und Opportunismus im Vergleich Mensch vs. Maschine sind fast keine Grenzen gesetzt. Es ist nicht nur forschungs- sondern auch massenwirksam, eine vielversprechende Konstellation. Gesunde Skepsis und Realismus sind geboten, denn wie oben beschrieben, ist der menschliche Geist noch lange nicht ergründet und es wäre gefährlich, auf etwas so vagem definitive Schlüsse zu ziehen. Was kann also festgehalten werden, denn zwecklos ist der Vergleich sicher nicht. Für welchen Zweck lohnt sich so ein Vergleich? Am Beispiel der Künstlichen Neuronalen Netzwerke im Human Brain Project, wurde ein wichtiger Zweck schon sehr deutlich. Übertragen auf die psychologische Forschung könnten auch hier gewinnbringende Symbiosen entstehen: Denn die KI und der menschliche Organismus sind in einigen Elementen konzeptionell verbunden und können sich inhaltlich und methodisch befruchten. Folgendes Beispiel verdeutlicht, wie eine Verschmelzung der Forschung an KI und Psychologie in einem Anwendungsfall aussehen könnte:

Versuchsaufbau: Es liegt die Hypothese zugrunde, dass ein gezieltes Priming Einfluss auf den positiven Vertrauensaufbau zu einer künstlichen Intelligenz hat. Hier werden Konzepte aus der Psychologie auf eine KI übertragen.

Einfache Form: UV → AV: Wenn positives Priming [UV: unabhängige Variable] → Dann positiver Vertrauensaufbau [AV: abhängige Variable]

Mit intervenierenden, moderierenden Variablen [IV, MV]: Diverse Variablen sollen erhoben werden, um mögliche Einflussfaktoren einzurechnen:

UV [Priming] → IV [Einstellung] ↔ MV [Alter] → AV [Vertrauen]

Für konkrete Anwendungsfälle als auch Generierung von Wissen, kommt man eigentlich nicht darum herum, den Mensch-Maschine Vergleich zu betrachten. Oberflächlich betrachtet scheint es nur allzu “logisch” zu sein, dass Computer die Logik der überlegenen Menschen annehmen sollen, um sie so effizient wie möglich zu machen. Daher wurden kognitive Prozesse untersucht, systematisiert und nachgebildet. Ob die Entwickler hier einer gewissen Hybris unterlegen sind, ist zumindest eine Diskussion wert. Denn nur allzu oft hat sich in einer Vielzahl wissenschaftlicher Studien gezeigt, dass Menschen alles andere als logisch denken und handeln. Sind Wahrnehmungsverzerrung, starke Gefühle, wie Hass, Liebe oder Angst, und Intuition nicht vielmehr Treiber von bewussten und unbewussten Gedanken, Entscheidungen und Handlungen?

Alles was rational ist, klare Regeln oder sehr guter Wahrscheinlichkeitsrechnung unterliegt, kann eine Maschine sicher besser, und macht sie daher in einem idealisierten Weltbild zu einer Verbündeten der Menschen. Im gleichen Atemzug ist die Menschheit in eine Abhängigkeit geraten, die keinen Rückweg vorsieht. So wie einst die Erlaubnis von Taschenrechnern in der Schule erst diskutiert werden musste, so muss in den nächsten Jahren diskutiert werden, ob KI in schwacher Form ein Teil des formalen Unterrichts wird und welche Rolle das Erlernen von Inhalten, das Auffinden und Evaluieren von wissenschaftlichen Daten einnehmen wird. Verantwortung und Recht muss neu definiert werden und Kreativität, kritisches Denken sowie Moral erhalten einen neuen Stellenwert.

Es handelt sich bei dem Thema also nicht nur um Effekthaschereien und Publicity (aber definitiv auch). Es ist deutlich ein Mehrwert einer Symbiose der Denkansätze zu erkennen. Unter der Prämisse, dass diese wissenschaftlichen Standards entsprechen. Es muss, wie Karl Popper formuliert hat, Licht ins Dunkle gebracht werden, Trial-and-Error heisst hier die Devise. Ob sich dann der Schwarze Zylinderhut zeigt, wo und in welcher Form, das ist noch in weiter Ferne. Doch der erste Schritt ist erreicht: Das Wissen um die Existenz dieses Zylinderhuts. Denn Fakt ist, sowohl die Informatik als auch die Neurowissenschaft oder die Psychologie, haben durch diese Interdisziplinarität weitreichende Fortschritte erzielt und die Forschung befindet sich immer noch ganz am Anfang. Die meisten positiven als auch negativen Ideen sind noch sehr visionär und weit von einer alltäglichen Anwendung entfernt. Das selbstfahrende Auto ist zwar technisch betrachtet in naher Zukunft und den menschlichen Fahrkünsten bereits überlegen, aber der Mensch, in seinem gesellschaftlichen Vertrauen und seiner eigenen “Evolution” ist eher träge und skeptisch, und das ist im Grunde genommen auch gut so.

Nehmen wir an, das Human Brain Project erreicht das erste, grosse Etappenziel, nämlich die synthetische Nachbildung eines kompletten Rattenhirns. Der nächste Schritt, wäre die komplette Rekonstruktion eines menschlichen Gehirns, mit all seinen neurologischen Funktionen. Auch wenn das Konstrukt physiologisch einwandfrei läuft, bleibt eine Frage unbeantwortet: Was verleiht den Zellen, neben der Funktionalität, Leben? Die wahre Kunst des menschlichen Gehirns ist es, über die neuronale Funktionalität von Hirn und Rückenmark, Bewusstsein zu schaffen. Alles andere ist nur leblose, wenn auch funktionierende Materie. Diese fast schon “sphärisch” anmutende Thema, ist im Fokus des nächsten Beitrages der Serie Psychologie Künstlicher Intelligenz: KI und Bewusstsein.

Quellenverzeichnis

Burks, A. (1946). Peirce’s Theory of Abduction. Philisophy of Sciences, 301-306.

Ang, C., et al. (2018). Mark Zuckerberg Ends Two Days of Testimony on Capitol Hill, New York Times: https://www.nytimes.com/2018/04/11/us/politics/zuckerberg-facebook-cambridge-analytica.html

Cognitive Computing Consortium (2018). https://cognitivecomputingconsortium.com/definition-of-cognitive-computing/

Deep Mind / AlphaGo (2018). https://deepmind.com/research/alphago/

Furber, F. (2016). Artificial Intelligence vs The Human Brain, Huffington Post: https://www.huffingtonpost.co.uk/steve-furber/artificial-intelligence-vs-the-human-brain_b_10434988.html

Harari, Y. N. (2015) Sapiens. A Brief History of Humankind. New York: HarperCollings Publisher

IBM Watson (2018). https://www.ibm.com/watson/

IEEE Standards, Code of Ethics (2017). The IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems. http://standards. ieee.org/develop/indconn/ec/autonomous_ systems.htm

Kelly, J.E. (2015). Computing, cognition and the future of knowing How humans and machines are forging a new age of understanding (White Paper, IBM Research)

Kroeber-Riel, Werner, Weinberg, P. Gröppel-Klein, A. (2009). Konsumentenverhalten. München: Vahlen

Popper, K.R. (1968). Was ist Dialektik? In: Ernst Topitsch (Hrsg.) : Logik der Sozialwissenschaften Bd., S. 262–290

Ruef, M. (2017). Artificial Intelligence – A Model for Humanity, SCIP AG: https://www.scip.ch/?labs.20180104

Tschopp, M. & Ruef, M. (2017). Development of an Artificial Intelligent Quotient. https://www.iaiqs.org/

Pinker, S. (2018). Enlightenment Now: a Manifesto for Science, Reason, Humanism, and Progress. New York: ALLEN LANE

Chatham, C. (2007). Science Blogs, 10 important differences between brains and computers: http://scienceblogs.com/developingintelligence/2007/03/27/why-the-brain-is-not-like-a-co/

Stone, P. et al. (2016). Artificial Intelligence and Life in 2030. One Hundred Year Study on Artificial Intelligence: Report of the 2015-2016 Study Panel, Stanford University, Stanford, CA

Zimbardo, P., Gerrig, R., & Graf, R. (2008). Psychologie. München: Pearson Education.

Unsere Spezialisten kontaktieren Sie gern!

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Unsere Spezialisten kontaktieren Sie gern!