Ist das Kunst? Persönliche Reflexionen über meine KI-Kunstwerke

Marisa Tschopp

Wie erzeugen Sie Vertrauen in Ihre KI-Lösung?

Es gibt unterschiedliche Gründe, warum Vertrauen im Kontext KI so an Popularität gewonnen hat. Wenn zum Beispiel im militärischen Kontext Leben gerettet werden können, indem Menschen in hochriskanten Situationen von Robotern ersetzt werden können (Yagoda und Gillan, 2012). Oder im Alltag, wenn es um selbstfahrende Fahrzeuge geht. Vertrauen hat schon immer eine grosse Rolle gespielt, wenn es um die Einführung neuer Märkte, Technologien oder Produkte wie E-commerce, das Fax oder Handys geht. Der Einfluss von Vertrauen auf Organisationen und Wirtschaft wird weiterbestehen, wenn es zum Beispiel darum geht, einen digitalen Assistent wie Alexa mit dem Wocheneinkauf zu beauftragen, statt in den hiesigen Supermarkt zu gehen.

Aber was macht das Thema Vertrauen und KI so reizvoll und wie ist es unterscheidbar von anderen technischen Innovationen? Ein Grund laut Siau und Wang (2018) ist, dass im Vergleich zu anderen Technologien, es an klaren prozeduralen Definitionen mangelt und die Leistung und Absichten der KI, insbesondere mit Blick auf die Intentionen der Provider, nicht klar sind. Überdies hinterlassen offene Fragen in Bezug auf ethische Standards, Forschung mit doppeltem Verwendungszweck, das Fehlen von Regulierung gepaart mit fragwürdigen Datenschutzbestimmungen, und nicht zuletzt die unanfechtbare Vorherrschaft der Tech-Giganten, einen schlechten Nachgeschmack. Firmen peppen ihre Produkte und Prozesse mit KI auf (AI-Washing), indem sie Roboter oder Hologramme nutzen, um unabhängig von Sinn und Zweck, Aufmerksamkeit in den Medien zu generieren. Es ist ziemlich klar, dass dies kein gutes Fundament für die Entstehung und Erhalt einer Vertrauensbeziehung darstellt.

Obwohl KI einen klaren Mehrwert für die Menschheit darstellen kann, beispielsweise bei der Krebsbekämpfung oder beim Klimawandel, wird KI oft kritisch betrachtet, vor allem weil der Hype um das Thema mit berechtigtem Widerstand einhergeht. Glücklicherweise, denn heutzutage wird Vertrauen nahezu inflationär verschenkt. So geht der Grossteil unreflektiert und vorschnell mit persönlichen Daten um (Botsman, 2017). An dieser Stelle lohnt es sich, etwas Abstand zu nehmen und sich eine alte Frage von Neuem zu stellen: Wem können wir vertrauen?

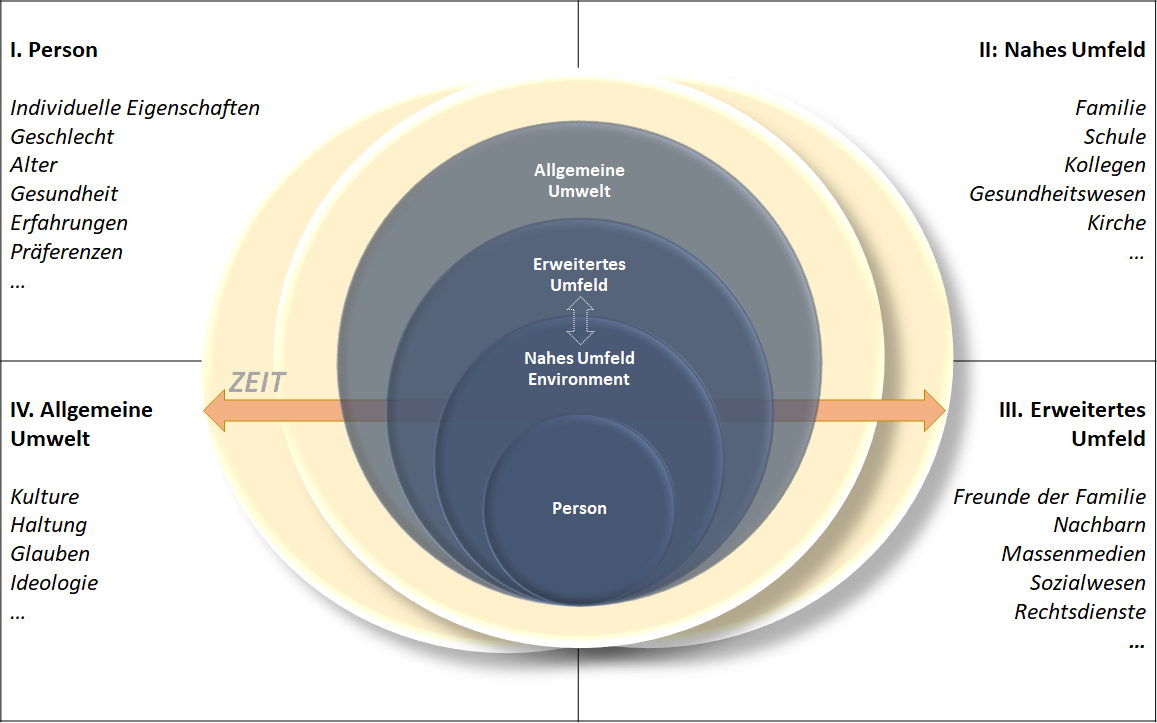

Die Natur des Vertrauens aus systemischer Perspektive zu untersuchen ist ein komplizierten Unterfangen, wenn es systematisch gemacht werden soll. Dieser Bericht versucht die wichtigsten Aspekte und Perspektiven zu integrieren, um dadurch ein ganzheitlicheres Bild zu schaffen. Die Rahmenbedingungen dafür sind inspiriert von dem Schalenmodell von Bronfenbrenners Ecological Systems Theory (2009). Des Weiteren, wurde unnötige Komplexität reduziert, wo auch immer möglich, beispielsweise in der Nomenklatur, welche geändert wurde in intuitiv verständliche Begriffe (z.B. allgemeine Umwelt anstatt Exosystem). Die nachstehende Grafik zeigt die unterschiedlichen Schalen oder Perspektiven, von der Person bis zur nationalen Kultur, wobei auch zeitliche Faktoren integriert werden. Dieser Überblick erhebt keinen Anspruch auf Vollständigkeit, sondern dient eher als Quelle der Inspiration und Exemplum für die vielen unterschiedlichen Möglichkeiten, Fragestellungen im Forschungskontext zu platzieren.

Im Allgemeinen, wird Vertrauen sowohl mit dynamischen als auch stabilen Eigenschaften assoziiert, mit einer Vielzahl an möglichen Fragestellungen und eng verwobenen Begriffen. Der Fokus kann sowohl auf eher statische Attribute persönlicher Vertrauensfaktoren gelegt werden, als auch auf eine eher dynamische Perspektive, welche Vertrauen als einen Prozess betrachtet, der sich auf dem Spektrum der Bildung, Erhalt, Entwicklung sowie Zerstörung und Wiederaufbau von Vertrauen, bewegt. Situative Faktoren vom historischen Kontext zur Kultur oder organisationale Strukturen, müssen beachtet werden, um moderierende Effekte zu erforschen. Ein beliebter, eher marktbestimmter Forschungsansatz, ist die Exploration von Bedingungen für den Vertrauensaufbau (sogenannte Antezedenten), als auch die Merkmale einer eins-zu-eins Vertrauensbeziehung.

Auf den Punkt gebracht, Forschungsfragen und Definitionen betrachten die Person, die Beziehung, die Situation und/oder den Prozess.

Die begrifflichen Unklarheiten, inhaltliche Überlappungen und der ständige Gebrauch im Alltag, erschweren das Thema Vertrauen und KI zusätzlich: Die Rolle von Kontrolle, Bildung und Wissen, Bias und Wahrnehmungsverzerrungen, Eigenschaften einer Interaktion, Kosten-Nutzen basiertes Vertrauen, Reduktion von Komplexität, Konsequenzen von Vertrauensbrüchen, Risiko, vergangen Erfahrungen, künftige Erwartung, Verletzlichkeit, eingeschränkte Rationalität, Erwartungs-Management, Unsicherheit in Wirtschaft und Konjunktur und noch viel mehr.

Im zwischenmenschlichen Bereich spielen Begriffe wie Integrität, Ehrlichkeit, Wohlwollen und Authentizität eine Rolle, während im Mensch-Maschine Interaktionsbereich Kompetenz, Fähigkeiten, Zuverlässigkeit von äusserster Wichtigkeit sind. Nicht zuletzt hat der Provider der Technologie einen starken Einfluss auf die Vertrauensbeziehung, was sich hauptsächlich auf Markenimage und wahrgenommene Gutmütigkeit bezieht, weshalb viele Tech-Firmen sich nun ihren Ethischen Mission Statements widmen (Botsmann, 2017; Hancock et al, 2012; Hengstler et al, 2015; Siau und Wang, 2018; Ullmann und Malle, 2018).

Auf dem Individual-Level, werden stabile, psychologische und biologische Faktoren der Person untersucht. Vertrauen als Persönlichkeitsmerkmal zu untersuchen, hat in der Psychologie eine traditionsreiche Geschichte, wobei diese dann mit anderen Faktoren korreliert werden, wie z.B. dem Fünf Faktoren Modell. Dabei kann untersucht werden, ob Offenheit oder Extraversion mit Vertrauen korreliert, was im Recruiting Einsatz finden kann, um zu testen, ob ein Soldat eine dispositionale Zu- oder Abneigung im Umgang mit Robotern hat.

Bis dato, haben Studien im Bereich der Mensch-Roboter-Interaktion (HRI) keine signifikanten Ergebnisse geliefert in Bezug auf Effekt der Persönlichkeit auf die Vertrauensbeziehung zwischen Mensch und Roboter. Eine Studie von Billings et al. (2012) im militärischen Umfeld zeigte, dass personen-bezogene Aspekte nur einen kleinen moderierenden Effekt auf die Entstehung von Vertrauen haben (ebenso wie umwelt-bezogene Aspekte).

In einer Metaanalyse, welche die Antezedenten von Vertrauen untersuchte, fanden Forscher heraus, dass die Eigenschaften, welche Roboterbezogen sind, den stärksten Effekt auf die Vertrauensbeziehung haben: Roboterbezogene Eigenschaften sind dabei Leistung, Erscheinungsbild und andere. Um Vertrauen messbar zu machen, wurden verschiedene Skalen verwendet, wie zum Beispiel die Interpersonal Trust Scale (Forbes und Rogers, 1999 in Billings et al., 2011) oder NARS (Negative Attitude towards Robots), welche die Einstellung gegenüber Robotern misst. Die aktuelle Forschung ist nahe daran, Trust Skalen im Bereich Mensch-Maschine Interaktion zu validieren, allerdings steht dort noch viel Arbeit bevor (Yagoda und Douglas, 2009; Ullmann und Malle, 2018).

Das nahe Umfeld untersucht situative Faktoren der näheren Umgebung, was im organisationalen Kontext mit der Team-Level Ebene verglichen werden kann. Von einer gesellschaftlichen Perspektive her, kann es durchaus interessant sein, einen genaueren Blick auf die Rolle der Familie oder Schulbildung zu werfen. In China werden bereits konkrete Pläne realisiert, KI in der frühen Schulbildung zu implementieren, wobei hier Themen wie geschichtliche Entwicklung und Anwendungsfälle behandelt werden. China verspricht sich durch die frühe Auseinandersetzung und ein grundlegendes Verständnis von KI, ökonomische und soziale Vorteile, da die Wahrscheinlichkeit für Vertrauen und Akzeptanz von KI dadurch gesteigert wird (eine Diskussion über die politischen und fragwürdigen Motive für den Einsatze von KI wird an dieser Stelle bewusst ausgelassen).

Führungsforschung kann auch hier in diesem Kontext platziert werden, welche sich mit den Auswirkungen von Führungsverhalten auf das Vertrauen und Akzeptanz von KI auseinandersetzen. Es bedarf noch an mehr explorativen Forschungsarbeiten, um Einsichten in die verschiedenen Führungsstile im Kontext KI zu erhalten: Welches Verhalten ist förderlich oder hinderlich und vor allem in welchem Kontext. Denn es macht einen grossen Unterschied, ob es sich um einen militärischen oder reinen Business Kontext handelt. Ebenso braucht es Studien, welche klare Abgrenzungskriterien zu anderen Technologien untersuchen (Thema Digital Leadership).

Im erweitertem Umfeld spielen die Medien vermutlich eine der wichtigsten Rollen, und wie KI in der aktuellen Medienlandschaft porträtiert wird. Wie ist die aktuelle Stimmung in den Medien in Bezug auf Hype versus KI-Winter und welchen Einfluss kann diese auf die Akzeptanz von KI haben? Was wird in Science-Fiction Filmen gezeigt und wie beeinflusst es die Mensch-KI Interaktion?

Auch hier wären explorative, grounded-theory Ansätze sinnvoll, welche hochwertige qualitative Daten mit quantitativen, ökonomischen Daten verbinden. Ziel ist es, Verhalten in Bezug auf Vertrauen und Akzeptanz zu beschreiben, erklären und vorherzusagen. Konkret könnte untersucht werden, welchen Effekt die aktuelle Agenda der Europäischen Union auf Forschung und Praxis hat. Ein Auszug aus einem aktuellen Pressestatement, beschreibt die Zielsetzung der EU:

Facilitating multistakeholder dialogue on how to advance AI innovation to increase trust and adoption and to inform future policy discussions is a commitment made as part of the recent G7’s Charlevoix Common Vision for the Future of Artificial Intelligence.

Auf diesem Level werden kulturelle Faktoren untersucht, welche das Vertrauen in KI beeinflussen, wobei hier noch wesentliche Lücken im Bereich vergleichender Kulturstudien bestehen.

Allerdings, können mehr Studien in der Zukunft erwartet werden, da dies eher ein methodischer Ansatz aus den Sozialwissenschaften ist, welche immer mehr Interesse und Eingang in die KI Forschung finden. So können zum Beispiel Unterschiede von kollektivistischen und individualistischen Kulturen und deren Korrelation mit Vertrauen und KI untersucht werden. Eine wichtige Frage in diesem Kontext, wäre der Effekt der politischen Agenda eines Landes auf das kollektive Vertrauen in KI.

Hier wird der zeitlich-historischen Situation Rechnung getragen. Was sind die Unterschiede heutzutage zu vergangen Vertrauensstudien vor 15-20 Jahren? Technologie hat sich sehr schnell entwickelt, wie sieht es mit dem Vertrauen darin aus? Die schwierigsten Fragen sind hier, welche longitudinal Studien können Sinn machen in diesem Kontext und von welcher Perspektive und in Bezug auf welche Technologie oder Provider?

Zusammenfassend kann dieser systemische Ansatz auf verschiedene Weisen nützlich sein:

Des Weiteren ist es wichtig, sich über alle Akteure in der Vertrauensbeziehung zwischen Mensch und Maschine im Klaren zu sein. Dabei gibt es den, der vertrauen soll und den, dem vertraut werden soll, dem Computer. Zuerst einmal, muss klar sein, welche Form oder Manifestation von KI verwendet werden soll und in welchem Kontext. Geht es um ein formloses Programm, welches Marktentscheidungen treffen soll oder einen KI gesteuerten Roboter, welcher als erweitertes Teammitglied in Kriegsregionen eingesetzt wird? Die Charakteristiken der Akteure spielen eine massgebliche Rolle, deswegen ist es unumgänglich diese im Vorhinein zu definieren und zu verstehen.

Schon jetzt, und auch in Zukunft, werden die Big-Player der Tech-industrie eine massgebende Rolle dabei spielen. Hype, Monopolismus und Komplexität werden die ständigen Begleiter der KI Ära sein, was eine Diskussion der Verantwortung der Tech-Giganten und ihrer Produkte zwingend erfordert. Dazu gehört auch die Frage nach Gesetzen und Regulationen, an welche die Verantwortlichkeiten geknüpft werden.

Diese Diskussion ist unumgänglich. Denn eigentlich, ist es nicht wirklich klar, ob die Akteure tatsächlich die Wahlfreiheit haben, KI zu vertrauen oder nicht. Es ist eher der Fall, dass die Menschheit sich in Richtung einer forcierten Vertrauensbeziehung mit KI bewegt, was konsequenterweise starken Widerstand und Skeptizismus zur Folge hat. (Zum Glück!)

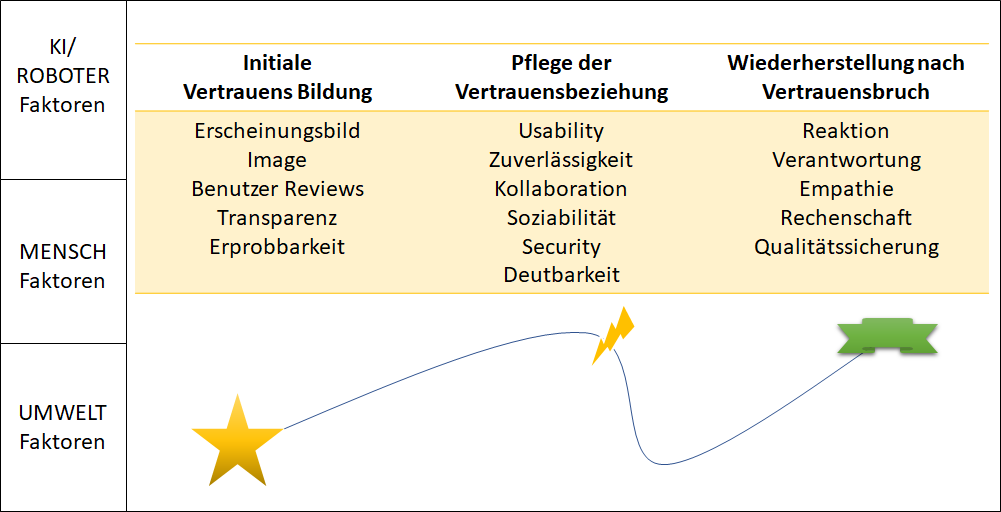

Obwohl in letzter Zeit viel gemacht worden ist in Bezug auf Vertrauen und KI, gibt es noch viele offene Fragen und Skalen zu validieren. Selbstverständlich, können nicht alle Teile in einer einzelnen Studie untersucht werden. Die folgende Grafik, basierend auf den Arbeiten von Botsman (2018), Siau & Wang (2018) und Sanders et al. (2015), schlägt mögliche Forschungsschwerpunkte vor, welche Schritt-für-Schritt, die einzelnen Teile zu einem grossen Ganzen zusammenfügen. Für Unternehmen in der Praxis, die die Möglichkeiten der KI ausloten wollen, ist es sinnvoll, dies ebenso Schritt-für-Schritt zu planen, bevor KI eingesetzt wird und vor allem wie es kontinuierlich evaluiert wird (Zeitdimension). Von der Bildung von Vertrauen und dessen Antezedenten bis zu der Wiederherstellung von Vertrauen, wenn dies einmal gebrochen wurde.

Der Umfang und Bereich von KI in Forschung und Praxis muss klar und präzise sein:

Diese Form der Situationsanalyse ist einer der kritischen Erfolgsfaktoren, wenn KI eingeführt werden soll. Diese Fragen müssen definiert und dargestellt werden, um alle Betroffenen zu erreichen und Widerstand zu reduzieren.

Seit Jahren betreut das Titanium Forschungsteam eine crowd-basierte Verwundbarkeitsdatenbank, welche Vulnerabilities und Exploits dokumentiert. Aktuell wurde ein Alexa Skill entwickelt, welche den Umgang mit dieser noch effizienter gestalten soll (Alexa ist Amazons digitaler Assistent). Unsicher darüber, ob Benutzer diesen digitalen Assistenten benutzen werden, wollte das Team herausfinden, wie das Vertrauen und damit die Anwendung dieser Alexa Skill verbessert werden kann. Nach der theoretischen Befassung mit dem Thema Vertrauen, wurde der Rahmen des neuen Forschungsprojektes definiert: Fokus liegt dabei auf die KI-bezogenen Eigenschaften. Ziel ist es, die Fähigkeiten von digitalen Assistenten zu demonstrieren, messen und vergleichen zu können.

Basierend auf empirischen Daten, wie wichtig die Kompetenz und Zuverlässigkeit in Bezug auf die Vertrauensbildung ist, hat das Team einen A-IQ entwickelt, einen künstlichen Intelligenz Quotient, als eine Methode, die Fähigkeiten einer KI zu messen. Es spiegelt menschliche IQ-Test-Prozeduren wider, um Fähigkeiten zu messen, zwischen digitalen Assistenten zu vergleichen und Weiterentwicklungen zu dokumentieren. Des Weiteren, aus Entwickler-Perspektive, kann das System verbessert werden, indem Schwächen im System durch den Test aufgedeckt werden.

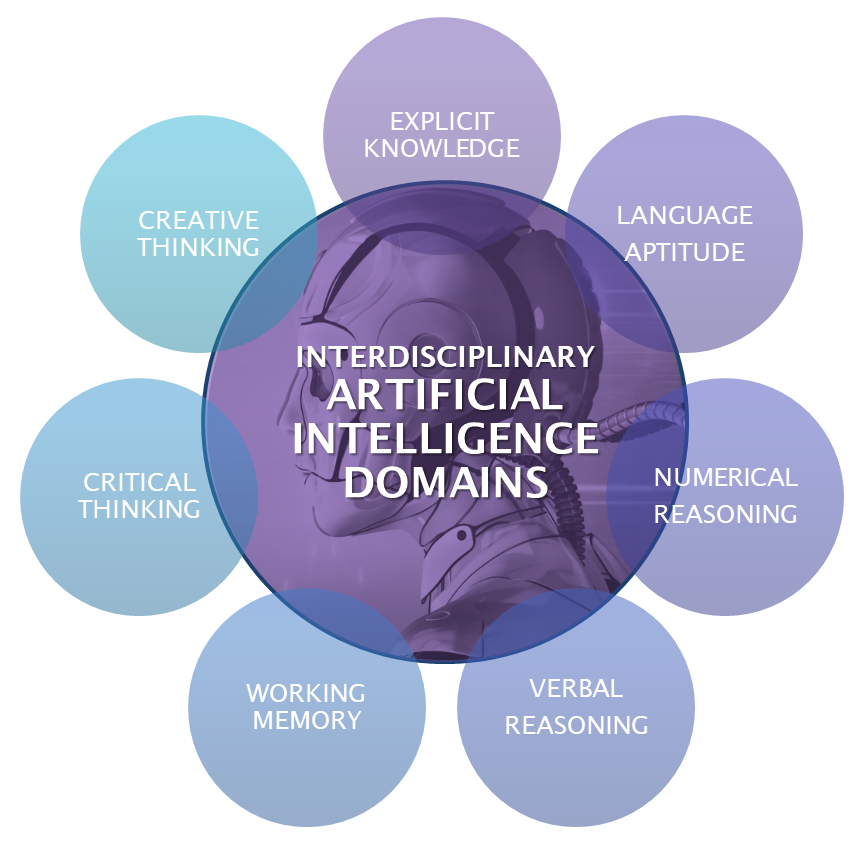

Aus einer interdisziplinären Perspektive, wurde die iAIQS entwickelt, eine Skala mit derzeit über 60 Items und multi-level Evaluationssystem, um Fähigkeiten zu testen und diese mit menschlichen intellektuellen Fähigkeiten zu vergleichen. Der theoretische Rahmen, basiert auf den 7 KI-Domänen Explizites Wissen (Explicit Knowledge), Sprachfertigkeiten (Language Aptitude), Verbale und Numerische Logik (Verbal und Numerical Reasoning), Kreatives und Kritisches Denken (Creative and Critical Thinking) sowie Arbeitsgedächtnis (Working Memory). Der Test wurde konstruiert für digitale Assistenten, Chatbots, und andere sprachgesteuerte Systeme.

Persönliche digitale Assistenten wurden entwickelt, um Menschen bei verschiedenen Aufgaben zu unterstützen mit unterschiedlicher Komplexität. Eine natürliche Handhabung und Interaktion durch Sprache ist essentiell, um von den Vorteilen und Möglichkeiten von KI Systemen zu profitieren. Die Argumentationsgrundlage einen menschlichen IQ Test zu adaptieren, liegt darin, genau diese Interaktion zu verbessern. Der A-IQ dient als eine Art Vertrauenssiegel, da es möglichst objektiv die Kompetenzen von digitalen Assistenten messen und beweisen soll (vergleiche hierzu Finkel, 2018).

Dieses Forschungsprojekt soll interdisziplinären Austausch anregen, ebenso wie ein tieferes Verständnis der Fähigkeiten und Nutzen von KI basierten Systemen schaffen. Es basiert auf solider akademischer Forschung, welche den Fokus auf praktische Anwendbarkeit setzt. Der nächste Lab wird die theoretische Grundlage und Methodologie beschreiben, sowie die Ergebnisse der Pilotstudie mit Alexa, Siri, Google Now und Cortana erklären.

R. Billings, Deborah & E. Schaefer, Kristin & Chen, Jessie & Hancock, Peter. (2012). Human-robot interaction: Developing trust in robots. In: HRI ’12 Proceedings of the seventh annual ACM/IEEE international conference on Human-Robot Interaction, Pages 109-110

Botsman, R. (2017). Who Can You Trust?: Who can you trust?: How technology brought us together – and why it could drive us apart. London: Portfolio Penguin.

Bronfenbrenner, U. (Ed.). (2009). Ecology of Human Development: Experiments by Nature and Design. Cambridge: Harvard University Press.

Hancock, P.A., Billings, D.R., Schaefer, K. E., Chen, J.Y.C., de Visser, E.J., and Parasuraman, R. (2011). A meta-analysis of factors affecting trust in human-robot interaction. In: Human Factors 53 ,5, 517-527.

Hengstler, M.; Enkel, M. Duelli, S. (2016). Applied artificial intelligence and trust—The case of autonomous vehicles and medical assistance devices. In: Technological Forecasting and Social Change 105, S. 105–120.

Sanders, T. L., Volante, W., Stowers, K., Kessler, T., Gabracht, K., Harpold, B. (2015). The Influence of Robot Form on Trust. In: Proceedings of the Human Factors and Ergonomics Society Annual Meeting 59 (1), Pages 1510–1514.

Siau, K., Wang, W. (2018). Building Trust in Artificial Intelligence, Machine Learning, and Robotics. In: CUTTER BUSINESS TECHNOLOGY JOURNAL (31), S. 47–53.

Ullman, D., Malle, B. F. (2018). What Does it Mean to Trust a Robot? What Does it Mean to Trust a Robot?: Steps Toward a Multidimensional Measure of Trust. In: Proceedings of the International Conference on Human-Robot Interaction, Pages 263-264.

Yagoda, R. E., Gillan, D. J. (2012). You Want Me to Trust a ROBOT? The Development of a Human-Robot Interaction Trust Scale. In: International Journal of Social Robotics, 4(3), 235–248.

Unsere Spezialisten kontaktieren Sie gern!

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Unsere Spezialisten kontaktieren Sie gern!