Ist das Kunst? Persönliche Reflexionen über meine KI-Kunstwerke

Marisa Tschopp

So vermenschlichen wir Digitale Assistenten

Um die wahrgenommenen Beziehungen zwischen Mensch und KI zu untersuchen, haben wir denselben Ansatz gewählt, den Nass und Kollegen schon vor Jahren vorgeschlagen haben, basierend auf dem CASA-Paradigma , der Tendenz von Menschen, Computer als soziale Akteure zu behandeln. Im Wesentlichen geht es dabei um eine Theorie der zwischenmenschlichen Interaktion, in unserem Fall darum, wie Menschen über ihre Beziehungen zu anderen Menschen denken. Man kritzelt ‘Mensch’ heraus, setzt eine konversationelle KI ein, und schon kann man mit der Arbeit an der Theorie beginnen und Daten sammeln. Wir haben uns für eine Theorie entschieden, die in der Vergangenheit starke empirische Unterstützung erfahren hat, nämlich die Theorie der relationalen Modelle von Alan P. Fiske 1992. Im Kern besagt diese Theorie, dass “Motivation, Planung, Produktion, Verständnis, Koordination und Bewertung des menschlichen Soziallebens weitgehend auf Kombinationen von vier psychologischen Modellen beruhen können” (Fiske, 1992).

Auf der Grundlage dieser Überlegungen stellen wir die folgenden Forschungsfragen:

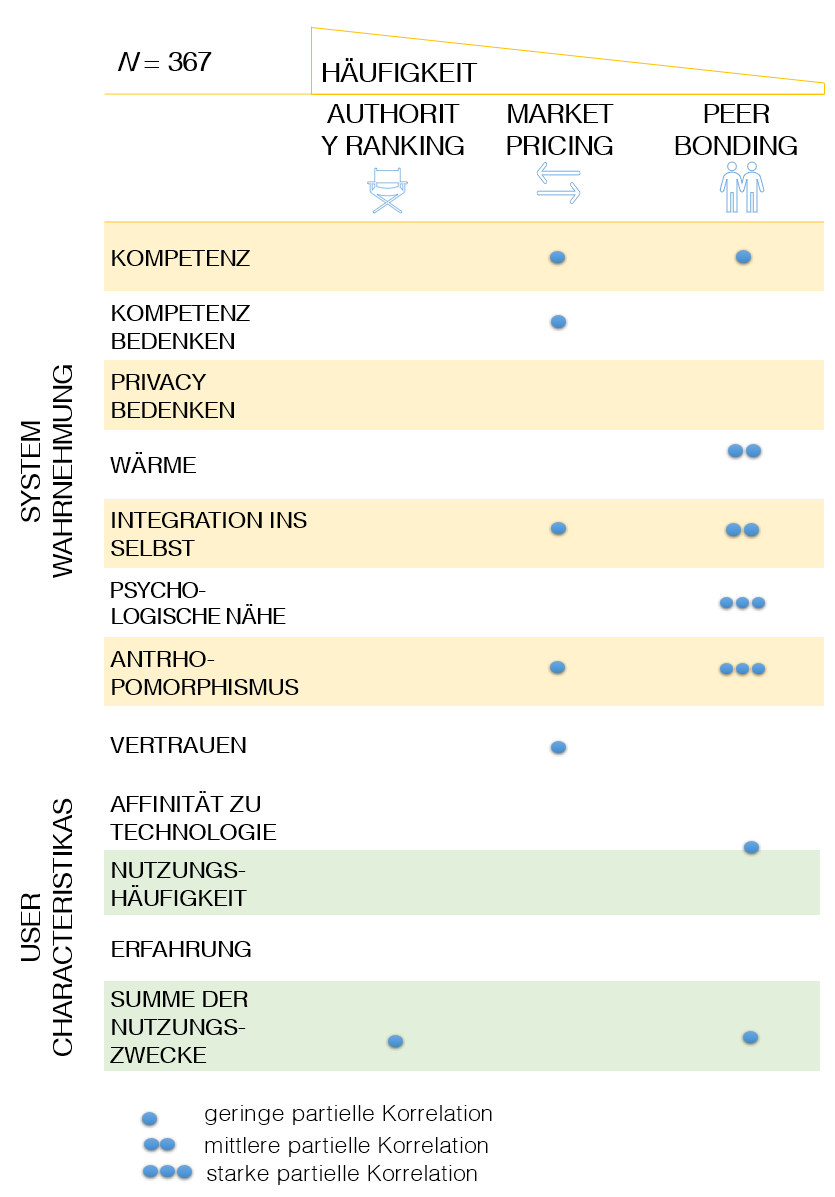

Methode: Wir haben eine Online-Fragebogenstudie auf Prolific mit 367 Teilnehmern durchgeführt und analysierten u.a. mittels Faktorenanalysen (PCA, CFA), wie die Teilnehmer die Mensch-KI-Beziehung wahrnehmen. Wir haben ausserdem eine Korrelationsanalyse gerechnet, welche die Variablen der Systemwahrnehmung und Benutzermerkmale einschloss, wobei wir bivariate und partielle Korrelationen untersuchten, um die Beziehungsmodi im breiteren Kontext der Mensch-Maschine-Interaktion besser zu verstehen.

Psychologen haben die Art und Weise, wie Menschen Beziehungen zu anderen Menschen bilden, aufbauen oder beenden, aus verschiedenen Perspektiven betrachtet. So zum Beispiel die Rolle von Nähe und Häufigkeit des Kontakts, d. h. wie nahe man beieinander wohnt oder wie oft man sich sieht: Sogar die Richtung, in der man die Tür zu einem Nachbarn öffnet, kann einen Einfluss darauf haben, wie eng die Beziehung zu diesem Nachbarn ist. Andere haben untersucht, wie sehr sie die andere Person in ihr Selbstverständnis integrieren, um die Beziehung zu definieren oder psychologische Nähe zu messen. Psychologische Nähe ist wichtig für gesunde Beziehungen, unabhängig davon, ob es sich um eine Freundschaft oder eine Liebesbeziehung handelt.

Alan P. Fiske (1992) hat die Theorie der Beziehungsmodelle (Haslam & Fiske, 1996) vorgeschlagen und dafür starke empirische Unterstützung erhalten, auch kulturübergreifend. In ihrer Theorie werden vier Modi erklärt, wie Menschen über ihre Beziehungen zu anderen Menschen denken, und sie können quantitativ in einem Fragebogen gemessen werden: Communal Sharing, Equality Matching, Authority Ranking und Market Pricing. Der Fragebogen enthält verschiedene Fragen, die sich auf jede dieser Dimensionen beziehen, um herauszufinden, wie die Teilnehmer über eine bestimmte Beziehung denken (die sie vor der Beantwortung der Fragen auswählen müssen) und dann den Grad ihrer Zustimmung auf einer Skala von “trifft überhaupt nicht zu” bis “trifft sehr zu” für diese bestimmte Beziehung bewerten.

Die vier elemantaren Formen von Beziehungen

| Communal Sharing | Equality Matching | Authority Ranking | Market Pricing |

|---|---|---|---|

| CS lässt sich am besten mit verwandtschaftlichen Beziehungen vergleichen, in denen Hierarchie keine Rolle spielt und man alles für die andere Person tut und keine Gegenleistung erwartet. Diese Dimension lässt sich mit Fragen wie “Sie beide sind eine Einheit: Sie gehören zusammen” messen. | EM erkennt ein Bedürfnis nach Gleichheit im Sinne von: Ich gebe dir etwas und du erwartest im Gegenzug etwas von gleichem Wert, das sogenannte wie du mir – so ich dir. Man kann es am besten mit Mitbewohnern in einer Wohnung vergleichen. Diese Dimension wird mit Fragen wie “Wenn Sie Arbeit zu erledigen haben, teilen sie diese normalerweise gleichmässig auf” gemessen. | AR vermittelt, dass zwischen den beiden Menschen eine Form von Hierarchie besteht. Sie wird mit Begriffen wie Dominanz und klaren Befehlsketten assoziiert, wie z. B. beim Militär. Diese Dimension wird mit Fragen wie “Einer von Ihnen ist der Anführer, der andere folgt loyal seinem Willen” gemessen. | Bei MP geht es um die Abwägung von Kosten und Nutzen in einer Beziehung. Menschen wollen eine Gegenleistung für ihre Investition in die Beziehung, z. B. Geld, wie es bei der Arbeit oder in Organisationen der Fall ist, in denen Menschen arbeiten. Diese Dimension wird mit Fragen wie “Was du von dieser Person bekommst, ist direkt proportional dazu, wie viel du ihr gibst” gemessen. |

Übertragung der Theorie und des Fragebogens auf die Mensch-Maschine Interaktion

Um die wahrgenommenen Beziehungen zwischen Mensch und KI mit Hilfe der Theorie der Beziehungsmodelle zu untersuchen, haben wir den ursprünglichen Fragebogen an den Kontext der konversationellen KI angepasst. Wir änderten den Wortlaut und fragten 15 Personen, ob die Fragen ihrer Meinung nach auf die wahrgenommenen Beziehungen zwischen Mensch und KI zutreffen.

Viel Aufmerksamkeit wird Variablen wie Vertrauen gewidmet, um besser zu verstehen, wie Menschen (wohl komplexe) Technologien wie KI oder automatisierte Systeme nutzen. Einige argumentieren sogar, dass Vertrauen in der Tat ein Proxy für die Messung von Beziehungen ist. Das macht Sinn, denn nach der Theorie der Beziehungsmodelle ist Vertrauen im Modus des Communal Sharing entscheidend (Stichworte: Verwandtschaft, Solidarität, In-Group – im Grunde die Frage: Was haben wir gemeinsam?), aber es ist somit nur ein Teil der Beschreibung einer Beziehung. Wir argumentieren, dass ein multidimensionaler Ansatz aus den Sozialwissenschaften vielversprechend ist, insbesondere im Zusammenhang mit standardmässiger Konversations-KI. Einige andere verwandte Arbeiten sind möglicherweise zu eng gefasst und nicht gut anwendbar. Zum Beispiel scheint die empirische Arbeit über soziale Präsenz zu kurz zu greifen, da sie ungenaue Differenzierung zulässt, z.B. wie diese soziale Präsenz charakterisiert wird, oder zuviel Spielraum für Interpretation lässt. Arbeiten im Bereich der Mensch-Maschine-Interaktion, kurz HMI, haben oft vordefinierte Rollen, z. B. den Roboter als Freund oder Assistent, was im KI-Konversationskontext, in dem die Rolle von Alexa etwas unklar ist, nicht gut passt. Sie könnte eine Assistentenrolle sein, wie angekündigt, könnte aber auch als Freundrolle wahrgenommen werden. Kurz gesagt, empirische, quantitative Forschung, die sich direkt auf die wahrgenommene Beziehung zwischen Menschen und Maschinen aus einer mehrdimensionalen Perspektive konzentriert, scheint rar zu sein (siehe z. B. McLean & Osei-Frimpong, 2019). Um diese Lücke zu schliessen, haben wir diese erste Studie durchgeführt, um die Beziehungen zwischen Mensch und KI direkt zu untersuchen. Wir hielten diesen multidimensionalen Ansatz für sehr vielversprechend, zumal er das Potenzial hat, über die traditionell dichotomen Unterscheidungen zwischen emotionalen und rationalen Dimensionen der menschlichen Wahrnehmung von KI-Systemen hinauszugehen (siehe z. B. Glikson & Woolley, 2020 für eine detaillierte Diskussion).

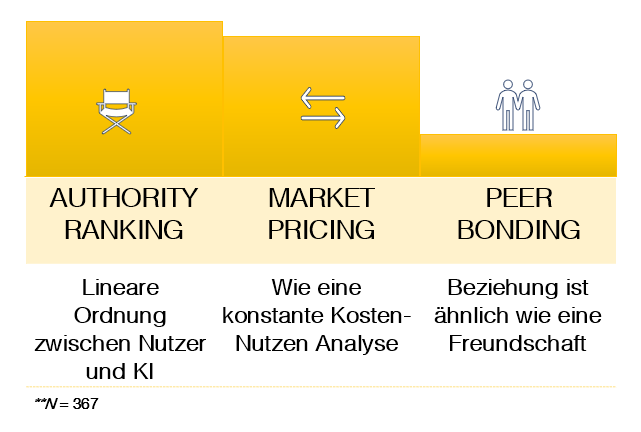

Unsere Faktorenanalyse ergab, dass die Beziehung zwischen Mensch und KI auf drei Dimensionen wahrgenommen wurde. Die beiden ursprünglichen Dimensionen Communal Sharing und Equality Matching verschmolzen zu einem Faktor, den wir als eher emotional empfanden. Wir nannten diesen dritten Faktor Peer Bonding. Somit blieben die folgenden drei Dimensionen übrig:

Eine genauere Betrachtung der Beziehungsmodi zwischen Mensch und KI ergab, dass die meisten Nutzer ihre Beziehung als hierarchische Eigentümer-Assistenten-Beziehung betrachteten (Authority Ranking). Ähnlich viele charakterisierten ihre Beziehung jedoch als nicht-hierarchischen Austausch (Market Pricing). Nur sehr wenige sahen ihre KI als eine gleichrangige oder freundschaftliche Beziehung an. Mit anderen Worten: Die Peer Bonding Dimension war in unseren Daten am wenigsten ausgeprägt. Dieses Ergebnis ist bereits recht interessant, da es die dichotome (rational-emotionale) Sichtweise, die im Bereich der HMI vorherrscht, bereichert.

Um zu sehen, wie sich die Beziehungsmodi in die traditionell untersuchten Variablen im breiteren HMI-Kontext einfügen, haben wir auch verschiedene Variablen unter der Kategorie Systemwahrnehmung und Nutzereigenschaften gemessen. Die partielle Korrelationsanalyse ergab, dass sowohl das Market Pricing als auch die Peer-Bonding Dimnension in der bivariaten und partiellen Korrelationsanalyse interessante Ergebnisse zeigten, was sie zu informativeren Dimensionen für zukünftige Forschung macht. Überraschenderweise bietet die traditionelle Assistentensicht keine aussagekräftigen Einblicke in die Systemwahrnehmung und Nutzereigenschaften. Interessanterweise korrelierte Peer Bonding nicht mit Vertrauen, wohingegen Market Pricing dies tat, was die emotionalen Aspekte von Vertrauen in Frage stellt und eine rationale Darstellung von Vertrauen in KI unterstützt.

Natürlich gibt es eine Reihe von Einschränkungen bei dieser explorative Forschungsarbeit. Zum Beispiel kamen die Teilnehmer überwiegend aus dem Vereinigten Königreich, so dass wir keine kulturübergreifenden Annahmen treffen können. Ausserdem haben wir nicht gemessen, wie sich der Ansatz der Beziehungsmodelle auf das Verhalten auswirkt. Mit anderen Worten, wir können keine Annahmen über die Auswirkungen auf das Nutzerverhalten machen. Aus diesem Grund führen wir nun eine Folgestudie durch, in der wir uns auf einen spezifischen Kontext konzentrieren, nämlich Voice Commerce. Voice Commerce (oder Voice Shopping) bedeutet, dass die Nutzer ihre Kaufentscheidungen ausschliesslich über ihren digitalen Assistenten treffen. Wir wollen also untersuchen, ob die wahrgenommenen Beziehungen zwischen Mensch und KI das Kaufverhalten beeinflussen, um konkretere Aussagen zu treffen, die auch für die Untersuchung des Nutzerverhaltens nützlich sein können (oder auch nicht).

Im Laufe unserer Forschung wollen wir stets die Vogelperspektive im Blick behalten und kritisch reflektieren, was die Konsequenzen unserer Ergebnisse und des Themas im Allgemeinen betrifft. Warum tun wir das? Wer profitiert davon? Wer könnte geschädigt werden? Wie werden die Ergebnisse von Designern verstanden? Wie kommunizieren wir unsere Forschung in der Praxis? Eines der grösseren Probleme ist der Anthropomorphismus (durch Design und durch den Benutzer) und das Potenzial zur Manipulation durch Design oder Benutzer, das ausgenutzt wird. Konversationsfähige KI-Systeme sind Hard- und Software, die mit dem Internet und den Geräten in unseren Haushalten verbunden sind und von KI angetrieben werden, was sie in die Lage versetzt, menschliche Sprache recht gut zu verarbeiten und in ähnlicher Weise zu antworten. Dennoch scheinen wir nicht in der Lage zu sein, eine klare Linie zu ziehen, um sie als das wahrzunehmen, was sie sind: Ein Werkzeug. Die Fähigkeit des Menschen, nicht-menschliche Wesen zu vermenschlichen, ist ein Segen, denn sie hilft uns, die Welt besser zu verstehen. Auf der anderen Seite ist sie aber auch ein Fluch, da sie so leicht ausgenutzt werden kann.

Wir hoffen, dass unsere Arbeit zu einem besseren Verständnis der Nutzer von KI-Systemen beitragen wird, um bessere Entscheidungen für die Entwicklung, Kommerzialisierung, Regulierung und/oder Nutzung von KI zu treffen. Wir möchten die Frage aufwerfen, wer von einem besseren Verständnis des Nutzers profitiert? Neben anderen Interessengruppen, wie z. B. den Regulierungsbehörden, die von einem besseren Verständnis der Nutzer profitieren, um sie zu schützen, soll hier auch die entscheidende Rolle der Entwickler angesprochen werden. Es liegt auf der Hand, dass Entwickler von einem besseren Nutzerverständnis profitieren, um bessere Systeme, bessere Schnittstellen, bessere Konversationen usw. zu entwickeln. Aber was macht ein “gutes” System aus? Die EU hat einige grossartige Ideen dazu in viele Bereiche, aber es scheint, dass die Forschung immer noch im Dunkeln tappt, wie viel Anthroporphismus durch Design in welchem Kontext gut ist.

Li, der Mitbegründer von Xiaoice, Microsofts Konversationsagenten mit über 600 Millionen Nutzern weltweit, bestätigte in einem Interview für die Hongkong Free Press (2021) die negativen Folgen, wie Sucht und Traurigkeit. Er ist jedoch nach wie vor der Meinung, dass die Vorteile dieser Technologie die Risiken überwiegen. Es bleibt also ein Dilemma: Wo ziehen wir die Grenze? Was unsere Forschung betrifft, so raten wir davon ab, die für diese Studie neu entwickelte Theorie der Beziehungsmodelle für Design- und Marketingstrategien anzuwenden, bis wir die grundlegende Theorie und die Folgen der Beziehungen zwischen Menschen und konversationeller KI besser verstehen.

Alexa, willst du mich heiraten? 6.000 Mal pro Tag machen Nutzer in Indien Alexa einen Heiratsantrag. Glücklicherweise wird ihre Liebe nicht erwidert: Wir sind an ziemlich unterschiedlichen Orten in unserem Leben. Buchstäblich. Ich meine, du bist auf der Erde und ich bin in der Cloud. – ist eine der Antworten auf die Millionen von Heiratsanträgen, die Alexa bisher erhalten hat. Dankenswerterweise sorgen verantwortungsbewusste Designer kommerziell verfügbarer KI dafür, dass die Nutzer immer darauf hingewiesen werden, dass diese Agenten Computersysteme sind, die keine Gefühle oder Gedanken haben. Nichtsdestotrotz hat unsere Studie im Einklang mit ähnlichen früheren Untersuchungen gezeigt, dass die Nutzer dennoch Gefühle empfinden, ihnen Handlungsfähigkeit zuschreiben und eine Beziehung zu konversationsfähiger KI wahrnehmen, die Ähnlichkeiten mit menschlichen Beziehungen aufweist. Wir glauben, dass uns dieses Thema noch eine Weile begleiten wird und wir können bei weitem keine umfassende Antwort geben. Aber wir hoffen, ein wenig mehr Licht auf ein besseres Verständnis dafür geworfen zu haben, wie Menschen ihre Beziehung zu KI wahrnehmen, und künftige Forschungen zu inspirieren, diese Perspektive zu berücksichtigen.

Dies ist eine kurze Zusammenfassung der ersten Forschungskooperation zwischen der scip AG und dem Social Processes Lab des Leibniz Instituts für Wissensmedien (Supervision: Prof. Dr. Kai Sassenberg), die auf der 5th AAAI/ACM conference on Artificial Intelligence Ethics, and Society (Oxford, August 1-3, 2022) präsentiert wurde

Unsere Spezialisten kontaktieren Sie gern!

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Unsere Spezialisten kontaktieren Sie gern!