Ist das Kunst? Persönliche Reflexionen über meine KI-Kunstwerke

Marisa Tschopp

So produzieren Sie mit einer Stimme ein Gesicht

Das Titanium Research Department beobachtet seit einigen Jahren die Entwicklungen im Bereich der Digitalen Assistenten (oft auch Conversational AI genannt). Dabei wurden bereits unterschiedliche Themen betrachtet, begonnen mit der Funktionsweise, Sicherheitsaspekten und Entwicklungspotential und der Rolle des Anthropomorphismus, also der Vermenschlichung von Maschinen. Kernaussage des letztgenannten Artikels ist, dass nur eine möglichst natürliche Konversation mit einem Sprachassistenten erst zum grossen Erfolg in puncto Akzeptanz und Nutzen führen wird. Von dem sind wir heute immer noch weit entfernt, trotz der imposanten Entwicklungen auf technologischer Ebene, wie die Aufführung der Restaurantreservierung durch den Google Duplex, der dem Restaurant ziemlich erfolgreich vorgegaukelt hat ein Mensch zu sein, schön illustriert.

Auf den anfänglichen Arbeiten aufbauend wurde daraufhin in einem grösseren interdisziplinär ausgerichteten Forschungsprojekt der A-IQ entwickelt, welcher eine Art IQ-Test für sprachgesteuerte, digitale Assistenten darstellt und damit auf spielerische Art und Weise der Erforschung der Kompetenzen der Sprachassistenten dienen soll. Die praktische Umsetzung der gewonnen Erkenntnisse erfolgte in der Entwicklung einer Alexa Skill für die VulDB (eine Verwundbarkeitsdatenbank, welche Schwachstellen dokumentiert, wodurch Administratoren und Sicherheitsexperten in ihrer Tätigkeit unterstützt werden).

Mit diesem Ansatz des Research from Within wollen wir kontinuierlich sowohl auf theoretischer als auch auf praktischer Ebene ein tiefes Verständnis von Sprache als Steuerungsinstrument der Zukunft aufbauen. Denn den Voice User Interfaces wird grosses Potential zugesprochen, doch zu der Ausgestaltung der Technologieimplementierung in Unternehmen stehen etliche Fragen offen, die aufgrund der Komplexität zwingend einen transdisziplinären Dialog benötigen.

Hätten VUI’s einen Beziehungsstatus, dann wäre es: Es ist kompliziert. Es gibt keine Off-the-Shelf Anwendungen, die man sich schnell kaufen kann, ohne dabei in eine gewisse Abhängigkeit zu geraten. Die Entwicklung und Implementierung brauchen Engagement, Zeit und Geld. Denn wie z.B. die Sprachinterfaces programmiert werden, also, ob der digitale Assistent Hey oder Guten Tag sagt, eine weibliche, männliche oder synthetische Stimme hat, humorvoll Witze macht oder, ob er Empfehlungen zu Sicherheitsmassnahmen während der Corona Krise geben soll, hat einen Effekt auf die Wahrnehmung.

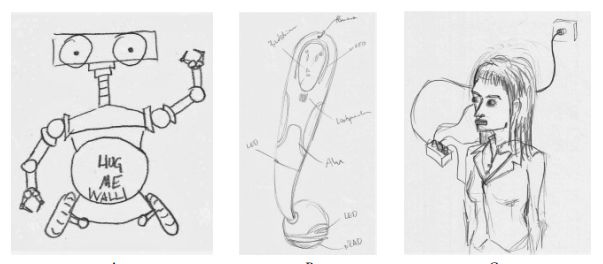

Hört ein Mensch eine Stimme, entsteht ein Bild im Kopf, das ist unausweichlich. In einer spannenden Studie der JK Universität Linz haben Forscher von Probanden Bilder malen lassen, wie sich die Probanden die Maschine vorstellen, abhängig von unterschiedlichen Stimmenklängen. So haben Menschen, Maschinen mit einer menschlichen Stimme öfter eine Nase gemalt, während gedanklichen Repräsentationen von Stimmen mit synthetisch/ computergeneriertem Klang, öfter Räder verliehen wurden (Mara et al., 2020).

Aus Sicht der Konsumentenpsychologie ist es sinnvoll zu verstehen, wie sich die unterschiedlichen Variablen auf die Wahrnehmung des einzelnen Users auswirken und welchen Effekt, das auf die Akzeptanz und damit das Nutzerverhalten hat. Einer dieser Variablen ist die sogenannte Brand Persona.

Befinden wir uns im Kontext Voice User Interfaces, bei dem kein Avatar oder Maskottchen mit der Stimme verbunden ist, wie z.B. Clippy, so reden wir (kurzgefasst) von einer Brand Persona, die eine rein gedankliche Manifestation in den Köpfen der Nutzer darstellt. Ein Bündel von Eindrücken einer Voiceanwendung wird zu einem Gebilde, das die Werte oder Image eines Unternehmens, die Bedürfnisse der Zielgruppe in Kombination mit der von der Voiceanwendung zu erledigender Aufgabe, widerspiegeln soll. Diese gilt es zu verstehen, denn ein:

Invisible Interface ist nicht Faceless (Studie von Metadesign zu Voice Branding)

Wally Brill, Head of Conversation Design Advocacy & Education bei Google, beschäftigt sich seit über 20 Jahren mit der Frage, wie einer Voiceanwendung ein Charakter verliehen werden kann und experimentiert mit den unterschiedlichsten Variablen, welche das Bild im Kopf der Konsumenten prägen soll, darunter z.B.:

Besonders wichtig erscheint die Art zu sprechen, oder der Jargon. Der nämlich ermöglicht den Programmierern die Wahrnehmung der Brand Persona, gezielt in eine Richtung zu beeinflussen. Am stark vereinfachten Beispiel, wie viele Möglichkeiten es gibt Ja zusagen, wird deutlich, wie vielschichtig der Prozess ist, die richtigen Worte zu wählen. Spricht der Assistent eher informell und humoristisch oder wie am Beispiel SBB, eher formell und emotionslos?

| Formelle JA’s | Ja, Gerne, Ok, [Bestätigung in Form von Paraphrasen] |

|---|---|

| Informelle JA’s | Klar, Logo, Okidoki, Logisch, Mhmm, Jo, Jup, 👍 [Emoji Daumen hoch],… |

Am Beispiel der Brand Persona wird schnell klar: Kennt eine Organisation ihr Image, ihre Werte, ihr Verhältnis zum Nutzer und die Aufgaben nicht, dann wird es schwer das richtige Ja zu wählen. Wie soll der digitale Assistent zum Kunden stehen? Als Dienender? Als Boss? Als Freund und Helfer? Diese Fragen müssen beantwortet werden bevor eine Voiceanwendung in die technische Konstruktion geht.

Übrigens: Mit einem Voiceprojekt kann man zwei (oder mehr) Fliegen mit einer Klappe schlagen. Aus organisationspsychologischer Sicht ist diese Vorübung allein schon lohnenswert, da sie in einem gemeinsamen Prozess, in dem Mitarbeiter und Führungskräfte involviert werden, diese spannenden Fragen der Unternehmenskultur bearbeiten und nach kreativen Lösungen suchen, ihre Mission nach aussen zu kommunizieren. Die kann sich positiv auf die Identifikation der Mitarbeiter mit dem Unternehmen auswirken, wie eine Art Teambildungmassnahme, die im Idealfall sogar noch einen Nutzen auf ökonomischer Sicht bringt.

In diesem Kontext soll zusätzlich noch auf den Unterschied von Chatbots und Voicebots eingegangen werden. Sprachanwendungen sind nicht einfach nur versprachlichte Chatbots oder FAQs. Sie unterscheiden sich von Chatbots in vielerlei Hinsicht, gerade im Design der Konversationen und der Brand Personas, wie Karen Kaushansky, Conversational Designer bei Google, in vielen Talks und Berichten predigt. Text und Voice funktionieren ganz anders, haben andere Designoptionen, wie bspw. kann ein textbasierter Chatbot mehr Optionen aufzeigen, während eine reine Voiceanwendung ohne Screen auf zwei bis drei Antwortoptionen eingeschränkt werden sollte. Bei unserer Alexa Skill für die VulDB beispielsweise, haben wir als zwei bis drei gesprochene Vorschläge, während noch weitere Informationen auf dem Monitor des Alexa Echo Show angegeben werden können.

Ein gesprochener Dialog basiert jedoch auf einem ganz anderen Muster bzw. Design. Ein Dialog kann in ganz viele verschiedene Richtungen verlaufen. Ein Text ist hingegen kontrolliert geführt und oft sehr logisch aufgebaut. Das heisst nicht, dass Dialoge nicht logisch verlaufen können, dennoch erscheinen sie auf eine ganz andere Art. Der entscheidende Unterschied lässt sich sehr gut anhand eines Vergleichs zum Chatbot-Modell aufzeigen: Beim Chatbot gibt es immer die Möglichkeit via Textausgabe mehrere Optionen für den weiteren Verlauf der Unterhaltung anzubieten (Das Design eines Voice User Interface – Alles andere als einfach, von Farner Lab, 2020)

Vor allem anderen, muss aber bedacht werden, dass das Design der Brand Persona nicht der erste und wichtigste Schritt ist, sondern zuerst der Use-Case, die Art des Zugriffs (z.B. Handy, Smart Speaker?), und die Multimodalität (z.B. Screen, no Screen?) geklärt werden muss:

Gehen wir auf das Beispiel SBB zurück: Was unterscheidet die Google Action als Voice Anwendung von einem textbasierten Chatbot? Für den, der bereits Voiceuser ist, ist es einfach komfortabel und entspricht seinen Präferenzen. Aber kann Silba auch neue nicht #Voicefirst Anhänger begeistern? Unser Fazit lautet: Jein. Ist das hier ein idealer Use-Case um eine Google Action zu produzieren?

Sicherlich konnte auf spielerischen Ebenen durch den netten SBB-Klang durchaus ein gewisser persönlicher Touch generiert werden. Auf der anderen Seite bringt der normale Google Assistant bereits sehr gute Ergebnisse, wenn man beispielsweise nach dem nächsten Zug nach Zürich fragt. In Bezug auf die SBB Google Action sind also noch einige Fragen offen, auch wenn der Anwendung sicher eine gewisse Liebe zum Detail zugestanden werden muss. Es muss sich noch zeigen, ob sich Silba durchsetzt, der Use-Case sticht auf jeden Fall nicht sehr deutlich heraus, wo doch genau dieser Raw Chicken Moment einer der wichtigsten Schritte im Design-Prozess ist. Dieser ist der Aha-Moment, und bezieht sich auf die Merkmale einer Situation, in der beide Hände nicht einsatzfähig sind und dadurch eine Voice-Anwendung erst richtig nützlich wird.

Ergänzend zu technischen und funktionalen Aspekten aus vorherigen Berichten, wurde in diesem Beitrag der Fokus auf die Thematik der Brand Persona im Voice User Interface Design gelegt. Brand Personas sind ein Teil vom Design Prozess, die das Bild der Voiceanwendung, also die Wahrnehmung des Konsumenten, prägt. Die Brand Persona beeinflusst durch ihre Designelemente das Vertrauen und die Sympathie der Konsumenten und wirkt sich dadurch auf das Nutzer- und Adoptionsverhalten aus.

Bevor eine Brand Persona gestaltet wird, müssen die Voraussetzungen geklärt werden: (1) Es ist ein guter Use-Case (Raw Chicken Moment) und die nötigen (2) Infrastrukturen, Daten und Ressourcen für eine Voice-Anwendung vorhanden. Hier kann eine Readinesscheck helfen, wie z.B. jener von voicefirst.ch. Wie geht es weiter, wenn die Basis stimmt?

Die Entwicklung der Brand Persona ist vielleicht nicht die kritischste aller Aufgaben im Voice User Interface Design, aber sie gehört durchaus zu den spassigen, kreativen Aufgaben, die auch auf Ebene der Unternehmenskultur wertvoll sein kann.

Dieser Beitrag wurde im Zuge des Weiterbildungskurse Voice User Interface Strategy der Hochschule Luzern geschrieben. Inhalte spiegeln Meinung der Autorin wider und lehnen sich an die Vorträge von Markus Maurer (Farner Lab), Karen Kaushansky und Wally Brill (Google Assistant Team) sowie Dr. Laura Dreessen (VUIagency) an.

Mara, M., Schreibelmayr, S., & Berger, F. (2020). Hearing a Nose? User Expectations of Robot Appearance Induced by Different Robot Voices. In HRI’20 Companion: ACM/IEEE Int. Conf. on Human-Robot Interaction, March 23-26, 2020, Cambridge, UK.

Unsere Spezialisten kontaktieren Sie gern!

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Marisa Tschopp

Unsere Spezialisten kontaktieren Sie gern!